Billede af redaktør

Vi har set store sprogmodeller (LLM'er) spytte ud hver uge, med flere og flere chatbots, som vi kan bruge. Det kan dog være svært at finde ud af, hvad der er bedst, fremskridtene på hver, og hvilken der er mest nyttig.

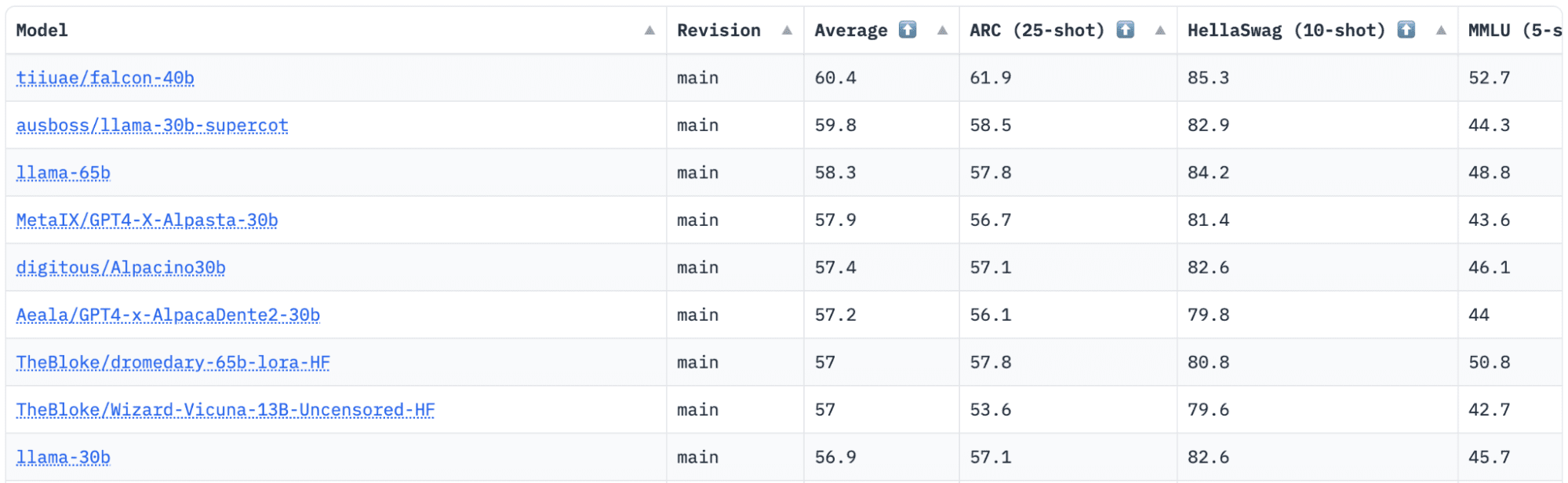

KrammerFace har en Open LLM Leaderboard, som sporer, evaluerer og rangerer LLM'er, efterhånden som de bliver frigivet. De bruger en unik ramme, som bruges til at teste generative sprogmodeller på forskellige evalueringsopgaver.

For nylig var LLaMA (Large Language Model Meta AI) øverst på ranglisten og er for nylig blevet detroniseret af en ny foruddannet LLM – Falcon 40B.

Billede af HuggingFace Open LLM Leaderboard

Falcon LLM blev grundlagt og bygget af Institut for teknologiinnovation (TII), en virksomhed, der er en del af Abu Dhabis regerings Advanced Technology Research Council. Regeringen fører tilsyn med teknologiforskning i hele De Forenede Arabiske Emirater, hvor holdet af videnskabsmænd, forskere og ingeniører fokuserer på at levere transformative teknologier og opdagelser inden for videnskab.

Falcon-40B er en grundlæggende LLM med 40B parametre, træning på en billion tokens. Falcon 40B er en autoregressiv dekoder-model. En autoregressiv dekoder-only model betyder, at modellen er trænet til at forudsige det næste token i en sekvens givet de foregående tokens. GPT-modellen er et godt eksempel på dette.

Falcons arkitektur har vist sig at overgå GPT-3 væsentligt for kun 75 % af træningsudregningsbudgettet, ligesom den kun kræver ? af beregningen på inferenstidspunktet.

Datakvalitet i stor skala var et vigtigt fokus for teamet på Technology Innovation Institute, da vi ved, at LLM'er er meget følsomme over for kvaliteten af træningsdata. Holdet byggede en datapipeline, der skaleres til titusindvis af CPU-kerner til hurtig behandling og var i stand til at udtrække indhold af høj kvalitet fra nettet ved hjælp af omfattende filtrering og deduplikering.

De har også en anden mindre version: Falcon-7B som har 7B parametre, trænet på 1,500B tokens. Samt en Falcon-40B-instruktionog Falcon-7B-instruktion tilgængelige modeller, hvis du leder efter en chatmodel, der er klar til brug.

Hvad kan Falcon 40B?

I lighed med andre LLM'er kan Falcon 40B:

- Generer kreativt indhold

- Løs komplekse problemer

- Kundeservice operationer

- Virtuelle assistenter

- Sprogoversættelse

- Følelsesanalyse.

- Reducer og automatiser "gentaget" arbejde.

- Hjælp emiratiske virksomheder med at blive mere effektive

Hvordan blev Falcon 40B trænet?

Da det blev trænet på 1 billion tokens, krævede det 384 GPU'er på AWS over to måneder. Trænet på 1,000B tokens af RefinedWeb, et massivt engelsk webdatasæt bygget af TII.

Fortræningsdata bestod af en indsamling af offentlige data fra nettet, vha CommonCrawl. Holdet gennemgik en grundig filtreringsfase for at fjerne maskingenereret tekst, og voksenindhold samt enhver deduplikering for at producere et fortræningsdatasæt på næsten fem billioner tokens blev samlet.

RefinedWeb-datasættet, der er bygget oven på CommonCrawl, har vist, at modeller opnår en bedre ydeevne end modeller, der er trænet på kuraterede datasæt. RefinedWeb er også multimodalt venligt.

Da den var klar, blev Falcon valideret mod open source benchmarks som EAI Harness, HELM og BigBench.

De har open source Falcon LLM for offentligheden, hvilket gør Falcon 40B og 7B mere tilgængelige for forskere og udviklere, da den er baseret på Apache License Version 2.0-udgivelsen.

LLM, som engang kun var til forskning og kommerciel brug, er nu blevet open source for at imødekomme den globale efterspørgsel efter inklusiv adgang til AI. Den er nu fri for royalties for restriktioner for kommerciel brug, da UAE er forpligtet til at ændre udfordringerne og grænserne inden for AI, og hvordan det spiller en væsentlig rolle i fremtiden.

Med det formål at dyrke et økosystem af samarbejde, innovation og videndeling i AI-verdenen, sikrer Apache 2.0 sikkerhed og sikker open source-software.

Hvis du vil prøve en enklere version af Falcon-40B, som er bedre egnet til generiske instruktioner i stil med en chatbot, vil du gerne bruge Falcon-7B.

Så lad os komme i gang ...

Hvis du ikke allerede har gjort det, skal du installere følgende pakker:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Når du har installeret disse pakker, kan du gå videre til at køre den forudsatte kode Falcon 7-B Instruct:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Falcon står som den bedste open source-model til rådighed, og har taget LLaMAs krone, og folk er overrasket over dens stærkt optimerede arkitektur, open source med en unik licens, og den er tilgængelig i to størrelser: 40B og 7B parametre.

Har du prøvet? Hvis du har, så lad os vide i kommentarerne, hvad du synes.

Nisha Arya er dataforsker, freelance teknisk skribent og Community Manager hos KDnuggets. Hun er særligt interesseret i at give Data Science karriererådgivning eller tutorials og teoribaseret viden omkring Data Science. Hun ønsker også at udforske de forskellige måder, kunstig intelligens er/kan gavne menneskets levetid. En ivrig lærende, der søger at udvide sin tekniske viden og skrivefærdigheder, samtidig med at hun hjælper med at vejlede andre.

Falcon LLM: The New King of Open-Source LLM'er – KDnuggets

Genudgivet af Platon

Billede af redaktør

Vi har set store sprogmodeller (LLM'er) spytte ud hver uge, med flere og flere chatbots, som vi kan bruge. Det kan dog være svært at finde ud af, hvad der er bedst, fremskridtene på hver, og hvilken der er mest nyttig.

KrammerFace har en Open LLM Leaderboard, som sporer, evaluerer og rangerer LLM'er, efterhånden som de bliver frigivet. De bruger en unik ramme, som bruges til at teste generative sprogmodeller på forskellige evalueringsopgaver.

For nylig var LLaMA (Large Language Model Meta AI) øverst på ranglisten og er for nylig blevet detroniseret af en ny foruddannet LLM – Falcon 40B.

Billede af HuggingFace Open LLM Leaderboard

Falcon LLM blev grundlagt og bygget af Institut for teknologiinnovation (TII), en virksomhed, der er en del af Abu Dhabis regerings Advanced Technology Research Council. Regeringen fører tilsyn med teknologiforskning i hele De Forenede Arabiske Emirater, hvor holdet af videnskabsmænd, forskere og ingeniører fokuserer på at levere transformative teknologier og opdagelser inden for videnskab.

Falcon-40B er en grundlæggende LLM med 40B parametre, træning på en billion tokens. Falcon 40B er en autoregressiv dekoder-model. En autoregressiv dekoder-only model betyder, at modellen er trænet til at forudsige det næste token i en sekvens givet de foregående tokens. GPT-modellen er et godt eksempel på dette.

Falcons arkitektur har vist sig at overgå GPT-3 væsentligt for kun 75 % af træningsudregningsbudgettet, ligesom den kun kræver ? af beregningen på inferenstidspunktet.

Datakvalitet i stor skala var et vigtigt fokus for teamet på Technology Innovation Institute, da vi ved, at LLM'er er meget følsomme over for kvaliteten af træningsdata. Holdet byggede en datapipeline, der skaleres til titusindvis af CPU-kerner til hurtig behandling og var i stand til at udtrække indhold af høj kvalitet fra nettet ved hjælp af omfattende filtrering og deduplikering.

De har også en anden mindre version: Falcon-7B som har 7B parametre, trænet på 1,500B tokens. Samt en Falcon-40B-instruktionog Falcon-7B-instruktion tilgængelige modeller, hvis du leder efter en chatmodel, der er klar til brug.

Hvad kan Falcon 40B?

I lighed med andre LLM'er kan Falcon 40B:

Hvordan blev Falcon 40B trænet?

Da det blev trænet på 1 billion tokens, krævede det 384 GPU'er på AWS over to måneder. Trænet på 1,000B tokens af RefinedWeb, et massivt engelsk webdatasæt bygget af TII.

Fortræningsdata bestod af en indsamling af offentlige data fra nettet, vha CommonCrawl. Holdet gennemgik en grundig filtreringsfase for at fjerne maskingenereret tekst, og voksenindhold samt enhver deduplikering for at producere et fortræningsdatasæt på næsten fem billioner tokens blev samlet.

RefinedWeb-datasættet, der er bygget oven på CommonCrawl, har vist, at modeller opnår en bedre ydeevne end modeller, der er trænet på kuraterede datasæt. RefinedWeb er også multimodalt venligt.

Da den var klar, blev Falcon valideret mod open source benchmarks som EAI Harness, HELM og BigBench.

De har open source Falcon LLM for offentligheden, hvilket gør Falcon 40B og 7B mere tilgængelige for forskere og udviklere, da den er baseret på Apache License Version 2.0-udgivelsen.

LLM, som engang kun var til forskning og kommerciel brug, er nu blevet open source for at imødekomme den globale efterspørgsel efter inklusiv adgang til AI. Den er nu fri for royalties for restriktioner for kommerciel brug, da UAE er forpligtet til at ændre udfordringerne og grænserne inden for AI, og hvordan det spiller en væsentlig rolle i fremtiden.

Med det formål at dyrke et økosystem af samarbejde, innovation og videndeling i AI-verdenen, sikrer Apache 2.0 sikkerhed og sikker open source-software.

Hvis du vil prøve en enklere version af Falcon-40B, som er bedre egnet til generiske instruktioner i stil med en chatbot, vil du gerne bruge Falcon-7B.

Så lad os komme i gang ...

Hvis du ikke allerede har gjort det, skal du installere følgende pakker:

Når du har installeret disse pakker, kan du gå videre til at køre den forudsatte kode Falcon 7-B Instruct:

Falcon står som den bedste open source-model til rådighed, og har taget LLaMAs krone, og folk er overrasket over dens stærkt optimerede arkitektur, open source med en unik licens, og den er tilgængelig i to størrelser: 40B og 7B parametre.

Har du prøvet? Hvis du har, så lad os vide i kommentarerne, hvad du synes.

Nisha Arya er dataforsker, freelance teknisk skribent og Community Manager hos KDnuggets. Hun er særligt interesseret i at give Data Science karriererådgivning eller tutorials og teoribaseret viden omkring Data Science. Hun ønsker også at udforske de forskellige måder, kunstig intelligens er/kan gavne menneskets levetid. En ivrig lærende, der søger at udvide sin tekniske viden og skrivefærdigheder, samtidig med at hun hjælper med at vejlede andre.

Mere om dette emne

Dette er de 10 værste amerikanske byer til at køre bil i 2024, rangeret – Autoblog

Industriens vagthund ser klager over service- og reparationsraket

Electron opsender sydkoreansk billeddannende satellit og NASA solsejl

Større ændringer godkendt til ClearSpace-1 mission

Tata Elxsi forbedrer flyproduktionens ydeevne gennem sine Industry 4.0-løsninger

Nigeria instruerer enheder til at identificere dem, der handler krypto med Bybit, KuCoin, OKX og Binance

Niels Steenstrup udnævnt til administrerende direktør for Thales InFlyt Experience – Thales Aerospace Blog

Strategisk mestring: RSBC's opkøb af STEYR ARMS katalyserer global ekspansion og produktsynergi – ACE (Aerospace Central Europe)

Bitcoin Bulls giver håb om svagere dollar for at forlænge rally

Bitcoin og Ethereum forbliver stabile i Asien, da handlende tøver med at forpligte sig til bullish eller bearish holdning - CryptoInfoNet