Selle postituse on kirjutanud Goktug Cinar, Michael Binder ja Adrian Horvath Boschi tehisintellekti keskusest (BCAI).

Tulude prognoosimine on enamiku organisatsioonide jaoks keeruline, kuid ülioluline ülesanne strateegiliste äriotsuste ja eelarveplaneerimise jaoks. Sageli teevad tulude prognoosimise finantsanalüütikud käsitsi ning see on nii aeganõudev kui ka subjektiivne. Sellised käsitsi tehtavad jõupingutused on eriti keerulised suuremahuliste rahvusvaheliste äriorganisatsioonide jaoks, kes nõuavad tuluprognoose mitmesuguste tooterühmade ja geograafiliste piirkondade kohta mitmel detailsustasemel. See eeldab mitte ainult prognooside täpsust, vaid ka hierarhilist sidusust.

Bosch on rahvusvaheline korporatsioon, mille üksused tegutsevad mitmes sektoris, sealhulgas autotööstus, tööstuslahendused ja tarbekaubad. Arvestades täpse ja sidusa tuluprognoosi mõju tervislikule äritegevusele, Boschi tehisintellekti keskus (BCAI) on palju investeerinud masinõppe (ML) kasutamisse, et parandada finantsplaneerimise protsesside tõhusust ja täpsust. Eesmärk on leevendada käsitsi tehtavaid protsesse, pakkudes ML kaudu mõistlikke algtaseme tuluprognoose, kusjuures finantsanalüütikud vajavad oma valdkonna- ja valdkonnateadmisi kasutades vaid aeg-ajalt korrigeerimisi.

Selle eesmärgi saavutamiseks on BCAI välja töötanud sisemise prognoosimise raamistiku, mis suudab pakkuda laiaulatuslikke hierarhilisi prognoose mitmesuguste baasmudelite kohandatud ansamblite kaudu. Meta-õppija valib igast aegreast eraldatud funktsioonide põhjal kõige paremini toimivad mudelid. Seejärel keskmistatakse valitud mudelite prognoosid, et saada koondprognoos. Arhitektuurne disain on modulaarne ja laiendatav REST-stiilis liidese rakendamise kaudu, mis võimaldab pidevat jõudluse parandamist lisamudelite kaasamise kaudu.

BCAI tegi koostööd Amazon ML Solutions Lab (MLSL), et hõlmata uusimad edusammud sügava närvivõrgu (DNN) põhistes mudelites tulude prognoosimiseks. Hiljutised edusammud närviprognoosides on näidanud tipptasemel jõudlust paljude praktiliste prognoosimisprobleemide lahendamiseks. Võrreldes traditsiooniliste prognoosimudelitega, saavad paljud närviprognoosid lisada aegridade täiendavaid ühismuutujaid või metaandmeid. Lisame CNN-QR ja DeepAR+, kaks valmismudelit Amazoni prognoos, samuti kohandatud Transformeri mudelit, mille abil on koolitatud Amazon SageMaker. Need kolm mudelit hõlmavad tüüpilist kodeerijate selgroogu, mida sageli kasutatakse närviprognoosides: konvolutsiooniline närvivõrk (CNN), järjestikune korduv närvivõrk (RNN) ja trafopõhised kodeerijad.

Üks peamisi väljakutseid, millega BCAI-MLSL partnerlus silmitsi seisis, oli usaldusväärsete ja mõistlike prognooside esitamine COVID-19 mõjul, mis on enneolematu ülemaailmne sündmus, mis põhjustab ülemaailmsetes ettevõtete finantstulemustes suurt volatiilsust. Kuna närviprognoosid on koolitatud ajalooliste andmete põhjal, võivad prognoosid, mis põhinevad volatiilsemate perioodide levitamata andmetel, olla ebatäpsed ja ebausaldusväärsed. Seetõttu tegime ettepaneku lisada selle probleemi lahendamiseks Transformeri arhitektuuri varjatud tähelepanu mehhanism.

Närviprognoosid saab koondada ühe komplekti mudelina või lisada eraldi Boschi mudeliuniversumisse ja neile on lihtne juurde pääseda REST API lõpp-punktide kaudu. Pakume välja lähenemisviisi närviprognooside koondamiseks tagasitesti tulemuste kaudu, mis tagab aja jooksul konkurentsivõimelise ja tugeva jõudluse. Lisaks uurisime ja hindasime mitmeid klassikalisi hierarhilise vastavusse viimise tehnikaid, et tagada prognooside ühtne koondamine tooterühmade, geograafiliste piirkondade ja äriorganisatsioonide lõikes.

Selles postituses näitame järgmist:

- Kuidas rakendada Forecasti ja SageMakeri kohandatud mudelikoolitust hierarhiliste, suuremahuliste aegridade prognoosimisprobleemide jaoks

- Kuidas kombineerida kohandatud mudeleid Forecasti valmismudelitega

- Kuidas vähendada häirivate sündmuste (nt COVID-19) mõju prognoosimisprobleemidele

- Kuidas luua AWS-is täielikku prognoosimise töövoogu

Väljakutsed

Tegelesime kahe väljakutsega: hierarhilise suuremahulise tuluprognoosi loomine ja COVID-19 pandeemia mõju pikaajalisele prognoosimisele.

Hierarhiline, suuremahuline tulude prognoosimine

Finantsanalüütikute ülesandeks on prognoosida peamised finantsnäitajad, sealhulgas tulud, tegevuskulud ning teadus- ja arendustegevuse kulud. Need mõõdikud annavad äriplaneerimise ülevaate erinevatel koondamistasanditel ja võimaldavad andmepõhist otsuste tegemist. Iga automaatne prognoosimislahendus peab pakkuma prognoose mis tahes äriliinide koondamise suvalisel tasemel. Boschis võib liite kujutada rühmitatud aegridadena kui hierarhilise struktuuri üldisema vormina. Järgmisel joonisel on kahetasandilise struktuuriga lihtsustatud näide, mis jäljendab Boschi hierarhilist tulude prognoosimise struktuuri. Kogutulu on toote ja piirkonna alusel jagatud mitmeks koondtasemeks.

Boschis prognoositavate aegridade koguarv ulatub miljonite skaalatesse. Pange tähele, et ülataseme aegridu saab jagada kas toodete või piirkondade kaupa, luues mitu teed alumise taseme prognoosideni. Tulu tuleb prognoosida hierarhia igas sõlmes 12 kuu pikkuse prognoosiperioodiga. Saadaval on igakuised ajaloolised andmed.

Hierarhilist struktuuri saab esitada järgmise vormi abil summeeriva maatriksi tähistusega S (Hyndman ja Athanasopoulos):

Selles võrrandis Y võrdub järgmisega:

Siin b tähistab alumise taseme aegrida ajahetkel t.

COVID-19 pandeemia mõjud

COVID-19 pandeemia tõi prognoosimisel kaasa olulisi väljakutseid, kuna see avaldab häirivat ja enneolematut mõju peaaegu kõigile töö- ja ühiskonnaelu aspektidele. Pikaajaliste tulude prognoosimisel tõi häire kaasa ka ootamatuid tagajärgi. Selle probleemi illustreerimiseks on järgmisel joonisel näidisaegrida, kus tootetulu langes pandeemia alguses märkimisväärselt ja taastus pärast seda järk-järgult. Tüüpiline närviprognoosimudel kasutab tuluandmeid, sealhulgas levitamata (OOD) COVID-perioodi ajaloolise konteksti sisendiks, ning mudelikoolituse põhitõde. Seetõttu ei ole koostatud prognoosid enam usaldusväärsed.

Modelleerimisviisid

Selles jaotises käsitleme erinevaid modelleerimisviise.

Amazoni prognoos

Prognoos on AWS-i täielikult hallatav AI/ML-teenus, mis pakub eelkonfigureeritud, nüüdisaegseid aegridade prognoosimudeleid. See ühendab need pakkumised oma sisemiste võimalustega automaatseks hüperparameetrite optimeerimiseks, ansambli modelleerimiseks (Forecasti pakutavate mudelite jaoks) ja tõenäosusprognooside genereerimiseks. See võimaldab hõlpsasti neelata kohandatud andmekogumeid, eeltöödelda andmeid, treenida prognoosimudeleid ja luua usaldusväärseid prognoose. Teenuse modulaarne disain võimaldab meil hõlpsalt küsida ja kombineerida paralleelselt välja töötatud täiendavate kohandatud mudelite ennustusi.

Kaasame Forecastist kaks närviprognoosi: CNN-QR ja DeepAR+. Mõlemad on järelevalve all olevad süvaõppe meetodid, mis treenivad globaalset mudelit kogu aegridade andmestiku jaoks. Nii CNNQR kui ka DeepAR+ mudelid suudavad vastu võtta staatilisi metaandmeid iga aegrea kohta, mis on meie puhul vastav toode, piirkond ja äriorganisatsioon. Samuti lisavad nad mudeli sisendisse automaatselt ajalisi funktsioone, nagu aasta kuu.

Tähelepanu maskidega transformer COVID-i jaoks

Transformeri arhitektuur (Vaswani et al.), mis oli algselt loodud loomuliku keele töötlemiseks (NLP), tõusis hiljuti populaarseks arhitektuurseks valikuks aegridade prognoosimiseks. Siin kasutasime jaotises kirjeldatud transformaatori arhitektuuri Zhou et al. ilma tõenäosusliku logi hõre tähelepanu. Mudel kasutab tüüpilist arhitektuurilist disaini, kombineerides kodeerija ja dekooderi. Tulude prognoosimiseks konfigureerime dekoodri nii, et see väljastaks otse 12-kuulise horisondi prognoosi, selle asemel, et genereerida prognoosi igakuiselt autoregressiivsel viisil. Aegridade sageduse põhjal lisatakse sisendmuutujana täiendavaid ajaga seotud funktsioone, nagu aasta kuu. Täiendavad kategoorilised muutujad, mis kirjeldavad metateavet (toode, piirkond, ettevõtte organisatsioon), suunatakse võrku koolitatava manustamiskihi kaudu.

Järgmine diagramm illustreerib transformaatori arhitektuuri ja tähelepanu maskeerimismehhanismi. Tähelepanu varjamine rakendatakse kõikidele kodeerija ja dekoodri kihtidele, nagu on esile tõstetud oranžiga, et vältida OOD-andmete prognooside mõjutamist.

Leevendame OOD konteksti akende mõju tähelepanu maskide lisamisega. Mudel on koolitatud pöörama väga vähe tähelepanu COVID-i perioodile, mis sisaldab maskeerimise kaudu kõrvalekaldeid, ja teostab prognoosimist maskeeritud teabega. Tähelepanu maski rakendatakse dekoodri ja kodeerija arhitektuuri igas kihis. Maskeeritud akent saab määrata käsitsi või kõrvalekallete tuvastamise algoritmi abil. Lisaks sellele, kui kasutate koolitussiltidena kõrvalekaldeid sisaldavat ajaakent, ei levitata kadusid tagasi. Seda tähelepanu maskeerimisel põhinevat meetodit saab rakendada muude haruldaste sündmuste põhjustatud häirete ja OOD-juhtumite käsitlemiseks ning prognooside tugevuse parandamiseks.

Mudelansambel

Mudelite ansambel ületab prognoosimisel sageli üksikuid mudeleid – see parandab mudeli üldistavust ja suudab paremini käsitleda aegridade andmeid, millel on perioodilisuse ja katkendlikkuse erinevad omadused. Lisame mudelite komplekti strateegiaid, et parandada mudeli jõudlust ja prognooside usaldusväärsust. Üks levinud süvaõppe mudelite ansambli vorm on tulemuste koondamine mudelite jooksudest, millel on erinevad juhuslikud kaalu algkäivitused või erinevatest treeningperioodidest. Kasutame seda strateegiat Transformeri mudeli prognooside saamiseks.

Erinevate mudeliarhitektuuride (nt Transformer, CNNQR ja DeepAR+) peale ansambli edasiseks ülesehitamiseks kasutame pan-mudel-ansambli strateegiat, mis valib iga aegrea jaoks tagasitesti tulemuste põhjal k kõige paremini toimivat mudelit ja hangib nende tulemused. keskmised. Kuna tagasitesti tulemusi saab eksportida otse treenitud prognoosimudelitest, võimaldab see strateegia meil kasutada võtmed kätte teenuseid, nagu prognoos, koos kohandatud mudelite (nt Transformer) täiustustega. Selline otsast lõpuni mudelite ansambli lähenemine ei nõua mudelivaliku jaoks meta-õppija koolitamist ega aegridade funktsioonide arvutamist.

Hierarhiline leppimine

Raamistik on kohanduv, et hõlmata hierarhilise prognooside vastavusse viimise järeltöötlusetappidena mitmesuguseid tehnikaid, sealhulgas alt-üles (BU), ülalt-alla kooskõlastamist prognoosimisproportsioonidega (TDFP), tavalist vähimruutu (OLS) ja kaalutud vähimruutu WLS). Kõik selle postituse katsetulemused on esitatud prognoosimise proportsioonidega ülalt-alla vastavusseviimise abil.

Arhitektuuri ülevaade

Töötasime AWS-is välja automatiseeritud täieliku töövoo, et luua tuluprognoose, kasutades selliseid teenuseid nagu Forecast, SageMaker, Amazoni lihtne salvestusteenus (Amazon S3), AWS Lambda, AWS-i astmefunktsioonidja AWS pilvearenduskomplekt (AWS CDK). Juurutatud lahendus pakub individuaalseid aegridade prognoose REST API kaudu Amazon API värav, tagastades tulemused eelmääratletud JSON-vormingus.

Järgmine diagramm illustreerib otsast lõpuni prognoosimise töövoogu.

Arhitektuuri peamised disainikaalutlused on mitmekülgsus, jõudlus ja kasutajasõbralikkus. Süsteem peaks olema piisavalt mitmekülgne, et hõlmata arenduse ja juurutamise ajal mitmesuguseid algoritme minimaalsete nõutavate muudatustega ning seda saab tulevikus uute algoritmide lisamisel hõlpsasti laiendada. Süsteem peaks lisama ka minimaalse üldkulud ja toetama paralleelset koolitust nii Forecasti kui ka SageMakeri jaoks, et vähendada treeninguaega ja saada kiiremini uusim prognoos. Lõpuks peaks süsteemi olema lihtne eksperimenteerimiseks kasutada.

Otsast lõpuni töövoog jookseb järjestikku läbi järgmiste moodulite:

- Eeltöötlusmoodul andmete ümbervormindamiseks ja teisendamiseks

- Mudelkoolitusmoodul, mis sisaldab nii prognoosimudelit kui ka kohandatud mudelit SageMakeris (mõlemad töötavad paralleelselt)

- Järeltöötlusmoodul, mis toetab mudelite komplekti, hierarhilist vastavust, mõõdikuid ja aruannete genereerimist

Step Functions korraldab ja juhib töövoogu olekumasinana otsast lõpuni. Olekumasina käitamine on konfigureeritud JSON-failiga, mis sisaldab kogu vajalikku teavet, sealhulgas ajalooliste tulude CSV-failide asukohta Amazon S3-s, prognoositavat algusaega ja mudeli hüperparameetri sätteid, et käitada otsast lõpuni töövoogu. Asünkroonsed kõned luuakse mudelitreeningu paralleelseerimiseks olekumasinas, kasutades lambda funktsioone. Kõik ajaloolised andmed, konfiguratsioonifailid, prognoositulemused ja vahepealsed tulemused, näiteks järeltestimise tulemused, salvestatakse Amazon S3-sse. REST API on üles ehitatud Amazon S3 peale, et pakkuda prognoositulemuste päringute tegemiseks päritavat liidest. Süsteemi saab laiendada, et lisada uusi prognoosimudeleid ja tugifunktsioone, nagu prognooside visualiseerimise aruannete genereerimine.

Hindamine

Selles jaotises kirjeldame üksikasjalikult katse seadistust. Põhikomponendid hõlmavad andmekogumit, hindamismõõdikuid, järeltestimise aknaid ning mudeli seadistamist ja koolitust.

Andmebaas

Boschi finantsprivaatsuse kaitsmiseks sisuka andmestiku kasutamise ajal kasutasime sünteetilist andmekogumit, millel on sarnased statistilised näitajad Boschi ühest äriüksusest pärit reaalse tulu andmestikuga. Andmekogum sisaldab kokku 1,216 aegrida, mille tulu registreeritakse igakuise sagedusega, hõlmates 2016. aasta jaanuarist 2022. aasta aprillini. Andmestik esitatakse 877 aegreaga kõige detailsemal tasemel (alumine aegrida) koos vastava rühmitatud aegridade struktuuriga. summeeriva maatriksina S. Iga aegrida on seotud kolme staatilise kategoorilise atribuudiga, mis vastavad tootekategooriale, piirkonnale ja organisatsiooniüksusele tegelikus andmekogumis (sünteetilistes andmetes anonüümseks muudetud).

Hindamismõõdikud

Mudeli toimivuse hindamiseks ja võrdleva analüüsi tegemiseks kasutame keskmise arktangendi absoluutse protsendi viga (mediaan-MAAPE) ja kaalutud MAAPE-d, mis on Boschi standardsed mõõdikud. MAAPE käsitleb keskmise absoluutse veaprotsendi (MAPE) puudusi, mida tavaliselt kasutatakse äritegevuses. Mediaan-MAAPE annab ülevaate mudeli toimivusest, arvutades iga aegrea kohta eraldi arvutatud MAAPE mediaani. Weighted-MAAPE teatab üksikute MAAPE kaalutud kombinatsioonist. Kaalud on iga aegrea tulu osakaal võrreldes kogu andmestiku koondtuluga. Kaalutud-MAAPE peegeldab paremini prognoosimise täpsuse mõju järgnevatele ettevõtetele. Mõlemad mõõdikud esitatakse kogu 1,216 aegrea andmestiku kohta.

Tagasitesti aknad

Kasutame mudeli jõudluse võrdlemiseks jooksvaid 12-kuulisi tagasitesti aknaid. Järgnev joonis illustreerib katsetes kasutatud tagasitesti aknaid ning toob esile vastavad treeningu ja hüperparameetrite optimeerimise (HPO) andmed. Pärast COVID-19 käivitumist testimise akende puhul mõjutavad tulemust OOD-sisendid 2020. aasta aprillist maini, lähtudes tulude aegridadest.

Mudeli seadistamine ja väljaõpe

Trafotreeningu jaoks kasutasime kvantiilikadu ja skaleerisime iga aegrea, kasutades selle ajaloolist keskmist väärtust, enne kui sisestasime selle Transformerisse ja arvutasime välja treeningkao. Lõplikud prognoosid skaleeritakse tagasi, et arvutada täpsusmõõdikud, kasutades rakenduses rakendatud MeanScalerit. GluonTS. Kasutame konteksti akent viimase 18 kuu igakuiste tuluandmetega, mis on valitud HPO kaudu tagasitestimise aknas ajavahemikus juulist 2018 kuni juunini 2019. Täiendavad metaandmed iga aegrea kohta staatiliste kategooriliste muutujate kujul sisestatakse mudelisse manustamise kaudu. kiht enne selle trafo kihtidesse söötmist. Treenime Transformerit viie erineva juhusliku kaalu algkäivitusega ja arvutame iga jooksu viimase kolme perioodi prognoositulemuste keskmise, kokku keskmiselt 15 mudelit. Viis näidistreeningu jooksu saab treeningu aja vähendamiseks paralleelselt ühendada. Maskiga Transformeri puhul märgime kõrvalekalleteks kuud 2020. aasta aprillist maini.

Kõigi Forecast mudeli koolituste jaoks lubasime automaatse HPO, mis saab valida mudeli ja treeningu parameetrid kasutaja määratud tagasitesti perioodi alusel, milleks on koolituse ja HPO jaoks kasutatavas andmeaknas seatud viimased 12 kuud.

Katse tulemused

Treenisime maskeeritud ja maskeerimata transformereid, kasutades sama hüperparameetrite komplekti, ja võrdlesime nende toimivust taganttesti akende puhul vahetult pärast COVID-19 šokki. Maskeeritud Transformeris on kaks maskeeritud kuud 2020. aasta aprill ja mai. Järgmises tabelis on esitatud 12. aasta juunist algava 2020-kuulise prognoosiaknaga järeltestimise perioodide tulemused. Võime täheldada, et maskeeritud Transformer ületab pidevalt maskeerimata versiooni. .

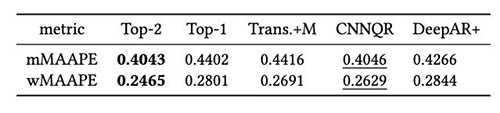

Lisaks hindasime mudeliansambli strateegiat tagasitesti tulemuste põhjal. Eelkõige võrdleme kahte juhtumit, kui valitakse ainult kõige paremini toimiv mudel, võrreldes kahe parima toimivusega mudeliga, ning mudeli keskmistamine toimub prognooside keskmise väärtuse arvutamise teel. Baasmudelite ja ansamblimudelite jõudlust võrdleme järgmistel joonistel. Pange tähele, et ükski närviprognoosija ei ületa jooksvates tagasitestimise akendes pidevalt teisi.

Järgmisest tabelist on näha, et keskmiselt annab parima tulemuse kahe parima mudeli ansambelmodelleerimine. CNNQR annab paremuselt teise tulemuse.

Järeldus

See postitus näitas, kuidas luua laiaulatuslike prognoosimisprobleemide jaoks täielik ML-lahendus, mis ühendab prognoosi ja SageMakeris koolitatud kohandatud mudeli. Sõltuvalt teie ärivajadustest ja ML-teadmistest saate prognoosimudeli koostamise, koolitamise ja juurutamise protsessi mahalaadimiseks kasutada täielikult hallatud teenust (nt Forecast); koostage SageMakeriga oma kohandatud mudel konkreetsete häälestusmehhanismidega; või teostada mudelite komplekteerimist, kombineerides kahte teenust.

Kui soovite abi ML-i kasutamise kiirendamisel oma toodetes ja teenustes, võtke ühendust Amazon ML Solutions Lab programmi.

viited

Hyndman RJ, Athanasopoulos G. Prognoosimine: põhimõtted ja praktika. OTexts; 2018 8. mai.

Vaswani A, Shazeer N, Parmar N, Uszkoreit J, Jones L, Gomez AN, Kaiser Ł, Polosukhin I. Tähelepanu on kõik, mida vajate. Edusammud närviinfotöötlussüsteemides. 2017;30.

Zhou H, Zhang S, Peng J, Zhang S, Li J, Xiong H, Zhang W. Informer: Lisaks tõhusale trafole pika järjestuse aegridade prognoosimiseks. InProceedings of AAAI 2021 2. veebruar.

Autoritest

Goktug Cinar on juhtiv ML-teadlane ning Robert Bosch LLC ja Boschi tehisintellekti keskuse ML-i ja statistikapõhise prognoosimise tehniline juht. Ta juhib prognoosimudelite, hierarhilise konsolideerimise ja mudelite kombineerimise tehnikate uurimist ning tarkvaraarenduse meeskonda, kes skaleerib neid mudeleid ja teenindab neid sisemise täieliku finantsprognoosimise tarkvara osana.

Goktug Cinar on juhtiv ML-teadlane ning Robert Bosch LLC ja Boschi tehisintellekti keskuse ML-i ja statistikapõhise prognoosimise tehniline juht. Ta juhib prognoosimudelite, hierarhilise konsolideerimise ja mudelite kombineerimise tehnikate uurimist ning tarkvaraarenduse meeskonda, kes skaleerib neid mudeleid ja teenindab neid sisemise täieliku finantsprognoosimise tarkvara osana.

Michael Binder on tooteomanik ettevõttes Bosch Global Services, kus ta koordineerib ettevõtteülese ennustava analüütikarakenduse arendamist, juurutamist ja juurutamist finantsnäitajate suuremahuliseks automatiseeritud andmepõhiseks prognoosimiseks.

Michael Binder on tooteomanik ettevõttes Bosch Global Services, kus ta koordineerib ettevõtteülese ennustava analüütikarakenduse arendamist, juurutamist ja juurutamist finantsnäitajate suuremahuliseks automatiseeritud andmepõhiseks prognoosimiseks.

Adrian Horváth on tarkvaraarendaja Boschi tehisintellekti keskuses, kus ta arendab ja hooldab süsteeme erinevatel prognoosimudelitel põhinevate prognooside loomiseks.

Adrian Horváth on tarkvaraarendaja Boschi tehisintellekti keskuses, kus ta arendab ja hooldab süsteeme erinevatel prognoosimudelitel põhinevate prognooside loomiseks.

Panpan Xu on vanemrakendusteadlane ja AWS-i Amazon ML Solutions Labi juht. Ta tegeleb masinõppe algoritmide uurimise ja arendusega, mis on mõeldud suure mõjuga kliendirakendustele erinevates tööstusvaldkondades, et kiirendada nende tehisintellekti ja pilve kasutuselevõttu. Tema uurimishuvi hõlmab mudeli tõlgendatavust, põhjuslikku analüüsi, inimese ahelas tehisintellekti ja interaktiivset andmete visualiseerimist.

Panpan Xu on vanemrakendusteadlane ja AWS-i Amazon ML Solutions Labi juht. Ta tegeleb masinõppe algoritmide uurimise ja arendusega, mis on mõeldud suure mõjuga kliendirakendustele erinevates tööstusvaldkondades, et kiirendada nende tehisintellekti ja pilve kasutuselevõttu. Tema uurimishuvi hõlmab mudeli tõlgendatavust, põhjuslikku analüüsi, inimese ahelas tehisintellekti ja interaktiivset andmete visualiseerimist.

Jasleen Grewal on Amazon Web Servicesi rakendusteadlane, kus ta töötab AWS-i klientidega, et lahendada masinõppe abil reaalseid probleeme, keskendudes eelkõige täppismeditsiinile ja genoomikale. Tal on tugev taust bioinformaatikas, onkoloogias ja kliinilises genoomikas. Ta on kirglik AI/ML-i ja pilveteenuste kasutamise vastu patsientide ravi parandamiseks.

Jasleen Grewal on Amazon Web Servicesi rakendusteadlane, kus ta töötab AWS-i klientidega, et lahendada masinõppe abil reaalseid probleeme, keskendudes eelkõige täppismeditsiinile ja genoomikale. Tal on tugev taust bioinformaatikas, onkoloogias ja kliinilises genoomikas. Ta on kirglik AI/ML-i ja pilveteenuste kasutamise vastu patsientide ravi parandamiseks.

Selvan Senthivel on ML-i vaneminsener AWS-i Amazon ML Solutions Labis, keskendudes klientide abistamisele masinõppe, süvaõppeprobleemide ja täielike ML-lahenduste vallas. Ta oli Amazon Comprehend Medicali insenerijuht ning aitas kaasa mitmete AWS-i AI-teenuste kavandamisele ja arhitektuurile.

Selvan Senthivel on ML-i vaneminsener AWS-i Amazon ML Solutions Labis, keskendudes klientide abistamisele masinõppe, süvaõppeprobleemide ja täielike ML-lahenduste vallas. Ta oli Amazon Comprehend Medicali insenerijuht ning aitas kaasa mitmete AWS-i AI-teenuste kavandamisele ja arhitektuurile.

Ruilin Zhang on SDE koos AWS-i Amazon ML Solutions Labiga. Ta aitab klientidel AWS AI teenuseid kasutusele võtta, luues lahendusi tavaliste äriprobleemide lahendamiseks.

Ruilin Zhang on SDE koos AWS-i Amazon ML Solutions Labiga. Ta aitab klientidel AWS AI teenuseid kasutusele võtta, luues lahendusi tavaliste äriprobleemide lahendamiseks.

Shane Rai on AWS-i Amazon ML Solutions Labi vanem ML-i strateeg. Ta teeb koostööd klientidega erinevates tööstusharudes, et lahendada nende kõige pakilisemad ja uuenduslikumad ärivajadused, kasutades AWS-i pilvepõhiseid AI/ML-teenuseid.

Shane Rai on AWS-i Amazon ML Solutions Labi vanem ML-i strateeg. Ta teeb koostööd klientidega erinevates tööstusharudes, et lahendada nende kõige pakilisemad ja uuenduslikumad ärivajadused, kasutades AWS-i pilvepõhiseid AI/ML-teenuseid.

Lin Lee Cheong on AWS-i Amazon ML Solutions Labi meeskonna rakendusteaduste juht. Ta teeb koostööd strateegiliste AWS-i klientidega, et uurida ja rakendada tehisintellekti ja masinõpet, et avastada uusi teadmisi ja lahendada keerulisi probleeme.

Lin Lee Cheong on AWS-i Amazon ML Solutions Labi meeskonna rakendusteaduste juht. Ta teeb koostööd strateegiliste AWS-i klientidega, et uurida ja rakendada tehisintellekti ja masinõpet, et avastada uusi teadmisi ja lahendada keerulisi probleeme.