Kép a szerkesztőtől

Hetente azt látjuk, hogy nagy nyelvi modellek (LLM) kiköpnek, és egyre több chatbotot használhatunk. Nehéz lehet azonban kitalálni, hogy melyik a legjobb, az egyes lépések előrehaladása és melyik a leghasznosabb.

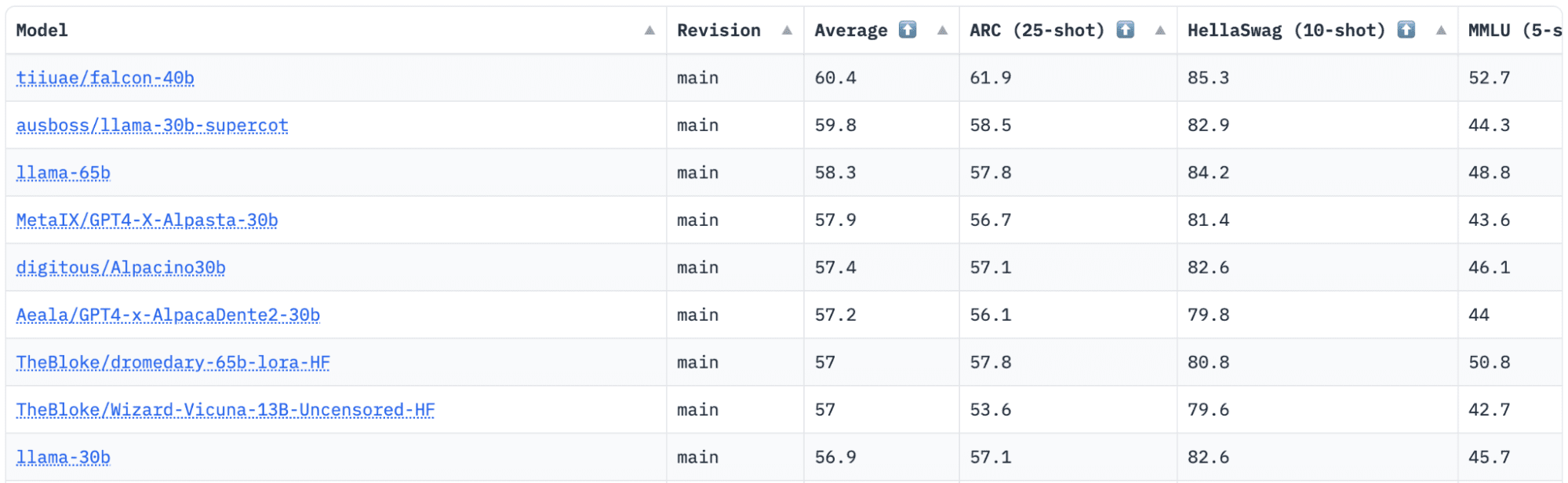

HuggingFace van egy nyílt LLM ranglistája, amely nyomon követi, értékeli és rangsorolja az LLM-eket a megjelenésükkor. Egyedülálló keretrendszert használnak, amelyet a generatív nyelvi modellek tesztelésére használnak különböző értékelési feladatokon.

A közelmúltban a LLAMA (Large Language Model Meta AI) állt a ranglista élén, és nemrégiben letaszította a trónjáról egy új, előre kiképzett LLM – Falcon 40B.

Kép HuggingFace Open LLM ranglista

Falcon LLM alapította és építette Technológiai Innovációs Intézet (TII), egy vállalat, amely az Abu Dhabi Kormány Fejlett Technológiai Kutatási Tanácsának tagja. A kormány felügyeli a technológiai kutatást az Egyesült Arab Emírségek egész területén, ahol a tudósokból, kutatókból és mérnökökből álló csapat a tudomány átalakító technológiák és felfedezések megvalósítására összpontosít.

Falcon-40B egy alapvető LLM 40B paraméterrel, egy billió tokennel edz. A Falcon 40B egy csak autoregresszív dekóderrel használható modell. Az autoregresszív dekódoló csak modell azt jelenti, hogy a modellt arra tanítják, hogy megjósolja a következő tokent az előző tokenek alapján. A GPT modell jó példa erre.

Bebizonyosodott, hogy a Falcon architektúrája jelentősen felülmúlja a GPT-3-at a képzési számítási költségkeret mindössze 75%-ában, valamint csak ? a számításból a következtetés időpontjában.

A Technológiai Innovációs Intézet csapatának fontos szempont volt a méretarányos adatminőség, mivel tudjuk, hogy az LLM-ek nagyon érzékenyek a képzési adatok minőségére. A csapat felépített egy adatfolyamot, amely több tízezer CPU magra méreteződött a gyors feldolgozás érdekében, és kiterjedt szűréssel és deduplikációval kiváló minőségű tartalmat tudott kinyerni az internetről.

Van egy másik kisebb verziójuk is: Falcon-7B amelynek 7B paramétere van, és 1,500B tokenre van kiképezve. Valamint a Falcon-40B-Instructés Falcon-7B-Instruct elérhető modellek, ha használatra kész chat-modellt keres.

Mit tud a Falcon 40B?

Más LLM-ekhez hasonlóan a Falcon 40B képes:

- Kreatív tartalmat generál

- Bonyolult problémák megoldása

- Ügyfélszolgálati műveletek

- Virtuális asszisztensek

- Language Translation

- Érzelemelemzés.

- Csökkentse és automatizálja az „ismétlődő” munkát.

- Segítsen az emírségekbeli vállalatoknak hatékonyabbá válni

Hogyan képezték ki a Falcon 40B-t?

Mivel 1 billió tokenre lett kiképezve, 384 GPU-ra volt szüksége AWS-en két hónapon keresztül. 1,000 milliárd tokenre képzett RefinedWeb, a TII által épített hatalmas angol webes adatkészlet.

Az előképzési adatok a webről származó nyilvános adatok gyűjteményéből álltak, segítségével CommonCrawl. A csapat egy alapos szűrési fázison ment keresztül, hogy eltávolítsa a géppel generált szöveget, és összeállították a felnőtteknek szánt tartalmakat, valamint az esetleges deduplikációkat, hogy egy közel ötbillió tokenből álló előképzési adatkészletet hozzanak létre.

A CommonCrawlre épülő RefinedWeb adatkészlet azt mutatta, hogy a modellek jobb teljesítményt érnek el, mint a kurált adatkészletekre betanított modellek. A RefinedWeb multimodálisbarát is.

Amint elkészült, a Falcont olyan nyílt forráskódú benchmarkokkal szemben validálták, mint az EAI Harness, a HELM és a BigBench.

Nekik van nyílt forráskódú Falcon LLM a nyilvánosság számára, így a Falcon 40B és 7B elérhetőbbé válik a kutatók és a fejlesztők számára, mivel az Apache License Version 2.0 kiadáson alapul.

Az egykor csak kutatási és kereskedelmi használatra szánt LLM mára nyílt forráskódúvá vált, hogy kielégítse az AI-hoz való inkluzív hozzáférés iránti globális keresletet. Mostantól jogdíjmentes a kereskedelmi felhasználásra vonatkozó korlátozásoktól, mivel az Egyesült Arab Emírségek elkötelezettek amellett, hogy megváltoztassák a mesterséges intelligencia kihívásait és határait, valamint azt, hogy a jövőben milyen jelentős szerepet játszik majd.

Az Apache 2.0, amely az együttműködés, az innováció és a tudásmegosztás ökoszisztémáját kívánja ápolni a mesterséges intelligencia világában, biztonságot és biztonságos nyílt forráskódú szoftvereket biztosít.

Ha szeretné kipróbálni a Falcon-40B egy egyszerűbb változatát, amely jobban megfelel az általános utasításokhoz egy chatbot stílusában, akkor a Falcon-7B-t szeretné használni.

Tehát kezdjük…

Ha még nem tette meg, telepítse a következő csomagokat:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Miután telepítette ezeket a csomagokat, folytathatja a megadott kód futtatását Falcon 7-B utasítás:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Az elérhető legjobb nyílt forráskódú modellként a Falcon megszerezte a LLaMA-k koronáját, és az embereket lenyűgözi az erősen optimalizált architektúra, a nyílt forráskódú egyedi licenccel, és két méretben is elérhető: 40B és 7B paraméterekkel.

Volt már próbája? Ha van, kommentben ossza meg velünk, mit gondol.

Nisha Arya adattudós, szabadúszó műszaki író és közösségi menedzser a KDnuggets-nél. Különösen érdekli az adattudományi karriertanácsadás vagy oktatóanyagok, valamint elméleti alapú ismeretek nyújtása a Data Science területén. Azt is szeretné feltárni, hogy a mesterséges intelligencia milyen különböző módokon járulhat hozzá az emberi élet hosszú élettartamához. Szívesen tanuló, aki igyekszik bővíteni műszaki ismereteit és íráskészségét, miközben segít másoknak.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- EVM Finance. Egységes felület a decentralizált pénzügyekhez. Hozzáférés itt.

- Quantum Media Group. IR/PR erősített. Hozzáférés itt.

- PlatoAiStream. Web3 adatintelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://www.kdnuggets.com/2023/06/falcon-llm-new-king-llms.html?utm_source=rss&utm_medium=rss&utm_campaign=falcon-llm-the-new-king-of-open-source-llms

Falcon LLM: A nyílt forráskódú LLM-ek új királya – KDnuggets

Újra kiadta Platón

Kép a szerkesztőtől

Hetente azt látjuk, hogy nagy nyelvi modellek (LLM) kiköpnek, és egyre több chatbotot használhatunk. Nehéz lehet azonban kitalálni, hogy melyik a legjobb, az egyes lépések előrehaladása és melyik a leghasznosabb.

HuggingFace van egy nyílt LLM ranglistája, amely nyomon követi, értékeli és rangsorolja az LLM-eket a megjelenésükkor. Egyedülálló keretrendszert használnak, amelyet a generatív nyelvi modellek tesztelésére használnak különböző értékelési feladatokon.

A közelmúltban a LLAMA (Large Language Model Meta AI) állt a ranglista élén, és nemrégiben letaszította a trónjáról egy új, előre kiképzett LLM – Falcon 40B.

Kép HuggingFace Open LLM ranglista

Falcon LLM alapította és építette Technológiai Innovációs Intézet (TII), egy vállalat, amely az Abu Dhabi Kormány Fejlett Technológiai Kutatási Tanácsának tagja. A kormány felügyeli a technológiai kutatást az Egyesült Arab Emírségek egész területén, ahol a tudósokból, kutatókból és mérnökökből álló csapat a tudomány átalakító technológiák és felfedezések megvalósítására összpontosít.

Falcon-40B egy alapvető LLM 40B paraméterrel, egy billió tokennel edz. A Falcon 40B egy csak autoregresszív dekóderrel használható modell. Az autoregresszív dekódoló csak modell azt jelenti, hogy a modellt arra tanítják, hogy megjósolja a következő tokent az előző tokenek alapján. A GPT modell jó példa erre.

Bebizonyosodott, hogy a Falcon architektúrája jelentősen felülmúlja a GPT-3-at a képzési számítási költségkeret mindössze 75%-ában, valamint csak ? a számításból a következtetés időpontjában.

A Technológiai Innovációs Intézet csapatának fontos szempont volt a méretarányos adatminőség, mivel tudjuk, hogy az LLM-ek nagyon érzékenyek a képzési adatok minőségére. A csapat felépített egy adatfolyamot, amely több tízezer CPU magra méreteződött a gyors feldolgozás érdekében, és kiterjedt szűréssel és deduplikációval kiváló minőségű tartalmat tudott kinyerni az internetről.

Van egy másik kisebb verziójuk is: Falcon-7B amelynek 7B paramétere van, és 1,500B tokenre van kiképezve. Valamint a Falcon-40B-Instructés Falcon-7B-Instruct elérhető modellek, ha használatra kész chat-modellt keres.

Mit tud a Falcon 40B?

Más LLM-ekhez hasonlóan a Falcon 40B képes:

Hogyan képezték ki a Falcon 40B-t?

Mivel 1 billió tokenre lett kiképezve, 384 GPU-ra volt szüksége AWS-en két hónapon keresztül. 1,000 milliárd tokenre képzett RefinedWeb, a TII által épített hatalmas angol webes adatkészlet.

Az előképzési adatok a webről származó nyilvános adatok gyűjteményéből álltak, segítségével CommonCrawl. A csapat egy alapos szűrési fázison ment keresztül, hogy eltávolítsa a géppel generált szöveget, és összeállították a felnőtteknek szánt tartalmakat, valamint az esetleges deduplikációkat, hogy egy közel ötbillió tokenből álló előképzési adatkészletet hozzanak létre.

A CommonCrawlre épülő RefinedWeb adatkészlet azt mutatta, hogy a modellek jobb teljesítményt érnek el, mint a kurált adatkészletekre betanított modellek. A RefinedWeb multimodálisbarát is.

Amint elkészült, a Falcont olyan nyílt forráskódú benchmarkokkal szemben validálták, mint az EAI Harness, a HELM és a BigBench.

Nekik van nyílt forráskódú Falcon LLM a nyilvánosság számára, így a Falcon 40B és 7B elérhetőbbé válik a kutatók és a fejlesztők számára, mivel az Apache License Version 2.0 kiadáson alapul.

Az egykor csak kutatási és kereskedelmi használatra szánt LLM mára nyílt forráskódúvá vált, hogy kielégítse az AI-hoz való inkluzív hozzáférés iránti globális keresletet. Mostantól jogdíjmentes a kereskedelmi felhasználásra vonatkozó korlátozásoktól, mivel az Egyesült Arab Emírségek elkötelezettek amellett, hogy megváltoztassák a mesterséges intelligencia kihívásait és határait, valamint azt, hogy a jövőben milyen jelentős szerepet játszik majd.

Az Apache 2.0, amely az együttműködés, az innováció és a tudásmegosztás ökoszisztémáját kívánja ápolni a mesterséges intelligencia világában, biztonságot és biztonságos nyílt forráskódú szoftvereket biztosít.

Ha szeretné kipróbálni a Falcon-40B egy egyszerűbb változatát, amely jobban megfelel az általános utasításokhoz egy chatbot stílusában, akkor a Falcon-7B-t szeretné használni.

Tehát kezdjük…

Ha még nem tette meg, telepítse a következő csomagokat:

Miután telepítette ezeket a csomagokat, folytathatja a megadott kód futtatását Falcon 7-B utasítás:

Az elérhető legjobb nyílt forráskódú modellként a Falcon megszerezte a LLaMA-k koronáját, és az embereket lenyűgözi az erősen optimalizált architektúra, a nyílt forráskódú egyedi licenccel, és két méretben is elérhető: 40B és 7B paraméterekkel.

Volt már próbája? Ha van, kommentben ossza meg velünk, mit gondol.

Nisha Arya adattudós, szabadúszó műszaki író és közösségi menedzser a KDnuggets-nél. Különösen érdekli az adattudományi karriertanácsadás vagy oktatóanyagok, valamint elméleti alapú ismeretek nyújtása a Data Science területén. Azt is szeretné feltárni, hogy a mesterséges intelligencia milyen különböző módokon járulhat hozzá az emberi élet hosszú élettartamához. Szívesen tanuló, aki igyekszik bővíteni műszaki ismereteit és íráskészségét, miközben segít másoknak.

Bővebben erről a témáról

These are the 10 worst U.S. cities for driving in 2024, ranked – Autoblog

Industry watchdog sees complaints over service and repair rocket

Electron launches South Korean imaging satellite and NASA solar sail

Major changes approved for ClearSpace-1 mission

Tata Elxsi is Improving Aircraft Manufacturing Performance Through its Industry 4.0 solutions

Nigéria utasítja az entitásokat, hogy azonosítsák azokat, akik a Bybit, a KuCoin, az OKX és a Binance kriptográfiai ügyletével foglalkoznak

Niels Steenstrup appointed CEO of Thales InFlyt Experience – Thales Aerospace Blog

Strategic mastery: RSBC’s acquisition of STEYR ARMS catalyzes global expansion and product synergy – ACE (Aerospace Central Europe)

A Bitcoin Bulls reményei szerint a gyengébb dollárban meghosszabbítja a rallyt

A Bitcoin és az Ethereum változatlan marad Ázsiában, mivel a kereskedők tétováznak a bullish vagy bearish álláspont mellett – CryptoInfoNet