Immagine dell'editore

Abbiamo visto grandi modelli linguistici (LLM) sputare fuori ogni settimana, con sempre più chatbot da utilizzare. Tuttavia, può essere difficile capire quale sia il migliore, i progressi su ciascuno e quale sia il più utile.

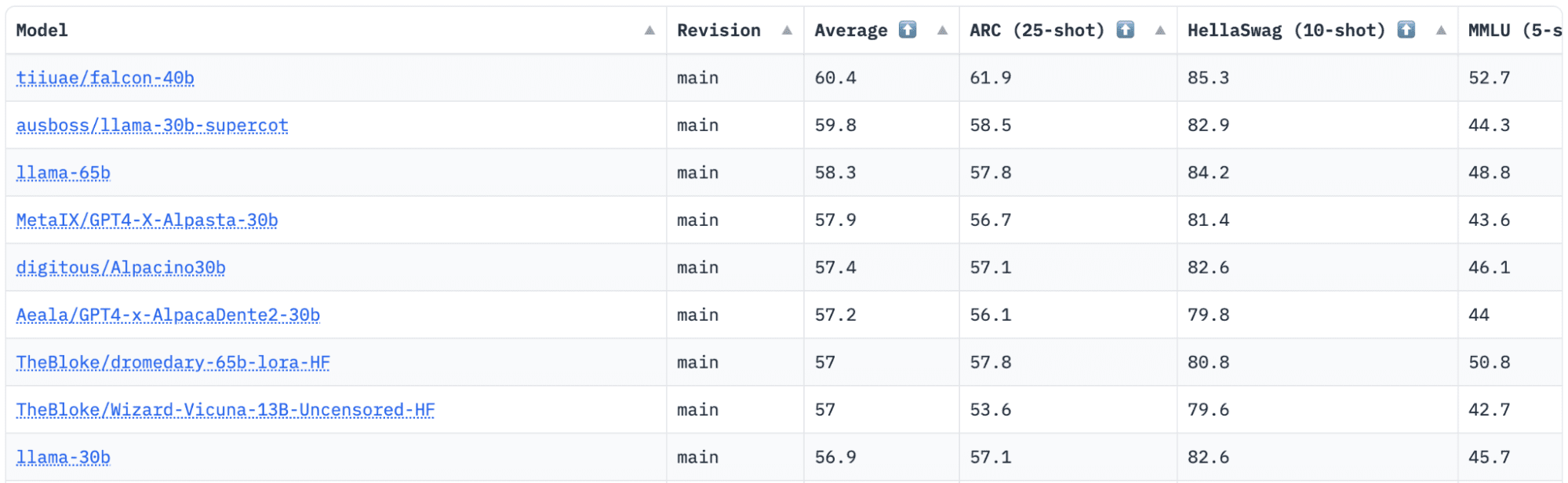

abbracciare il viso ha una classifica Open LLM che tiene traccia, valuta e classifica gli LLM man mano che vengono rilasciati. Usano un framework unico che viene utilizzato per testare modelli di linguaggio generativo su diversi compiti di valutazione.

Di recente, LLaMA (Large Language Model Meta AI) era in cima alla classifica ed è stato recentemente detronizzato da un nuovo LLM pre-addestrato: Falcon 40B.

Immagine di Classifica LLM aperta HuggingFace

Falco LLM è stata fondata e costruita dal Istituto per l'innovazione tecnologica (TII), una società che fa parte dell'Advanced Technology Research Council del governo di Abu Dhabi. Il governo sovrintende alla ricerca tecnologica in tutti gli Emirati Arabi Uniti, dove il team di scienziati, ricercatori e ingegneri si concentra sulla fornitura di tecnologie trasformative e scoperte scientifiche.

Falco-40B è un LLM fondamentale con parametri 40B, formazione su un trilione di token. Falcon 40B è un modello solo decoder autoregressivo. Un modello di solo decodificatore autoregressivo significa che il modello viene addestrato per prevedere il token successivo in una sequenza dati i token precedenti. Il modello GPT ne è un buon esempio.

L'architettura di Falcon ha dimostrato di superare in modo significativo GPT-3 solo per il 75% del budget di calcolo per l'addestramento, oltre a richiedere solo? del calcolo al momento dell'inferenza.

La qualità dei dati su larga scala è stata un obiettivo importante del team del Technology Innovation Institute, poiché sappiamo che gli LLM sono molto sensibili alla qualità dei dati di formazione. Il team ha creato una pipeline di dati scalabile fino a decine di migliaia di core della CPU per un'elaborazione rapida ed è stato in grado di estrarre contenuti di alta qualità dal Web utilizzando filtri e deduplicazione estesi.

Hanno anche un'altra versione più piccola: Falco-7B che ha parametri 7B, addestrati su token 1,500B. Così come un Falcon-40B-Istruzionee Falcon-7B-Istruzione modelli disponibili, se stai cercando un modello di chat pronto all'uso.

Cosa può fare Falcon 40B?

Simile ad altri LLM, Falcon 40B può:

- Genera contenuti creativi

- Risolvere problemi complessi

- Operazioni di assistenza clienti

- Assistenti virtuali

- Language Translation

- Analisi del sentimento.

- Riduci e automatizza il lavoro “ripetitivo”.

- Aiuta le aziende degli Emirati a diventare più efficienti

Come è stato addestrato il Falcon 40B?

Essendo stato addestrato su 1 trilione di token, ha richiesto 384 GPU su AWS, in due mesi. Addestrato su 1,000 miliardi di token di Web raffinato, un enorme set di dati web in inglese creato da TII.

I dati di pre-formazione consistevano in una raccolta di dati pubblici dal web, utilizzando Scansione comune. Il team ha attraversato un'accurata fase di filtraggio per rimuovere il testo generato dalla macchina e il contenuto per adulti, nonché qualsiasi deduplicazione per produrre un set di dati di pre-addestramento di quasi cinque trilioni di token è stato assemblato.

Basato su CommonCrawl, il set di dati RefinedWeb ha dimostrato che i modelli ottengono prestazioni migliori rispetto ai modelli addestrati su set di dati curati. RefinedWeb è anche multimodale.

Una volta pronto, Falcon è stato convalidato rispetto a benchmark open source come EAI Harness, HELM e BigBench.

Hanno Falcon LLM open-source al pubblico, rendendo Falcon 40B e 7B più accessibili a ricercatori e sviluppatori poiché si basa sulla versione Apache License Version 2.0.

Il LLM, che una volta era solo per la ricerca e per uso commerciale, è ora diventato open-source per soddisfare la domanda globale di accesso inclusivo all'IA. Ora è privo di royalty per le restrizioni sull'uso commerciale, poiché gli Emirati Arabi Uniti sono impegnati a cambiare le sfide e i confini all'interno dell'IA e come svolge un ruolo significativo in futuro.

Con l'obiettivo di coltivare un ecosistema di collaborazione, innovazione e condivisione delle conoscenze nel mondo dell'intelligenza artificiale, Apache 2.0 garantisce sicurezza e sicurezza del software open source.

Se vuoi provare una versione più semplice di Falcon-40B che è più adatta per istruzioni generiche nello stile di un chatbot, devi usare Falcon-7B.

Quindi iniziamo…

Se non lo hai già fatto, installa i seguenti pacchetti:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Dopo aver installato questi pacchetti, puoi quindi passare all'esecuzione del codice previsto Falcon 7-B Istruire:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Rappresentando il miglior modello open source disponibile, Falcon ha conquistato la corona di LLaMA e le persone sono stupite dalla sua architettura fortemente ottimizzata, open source con una licenza unica ed è disponibile in due dimensioni: parametri 40B e 7B.

Hai provato? Se avete, fateci sapere nei commenti cosa ne pensate.

Nisha Aria è Data Scientist, Scrittore tecnico freelance e Community Manager presso KDnuggets. È particolarmente interessata a fornire consulenza o tutorial sulla carriera in Data Science e conoscenze basate sulla teoria in Data Science. Desidera anche esplorare i diversi modi in cui l'Intelligenza Artificiale è/può giovare alla longevità della vita umana. Una studentessa appassionata, che cerca di ampliare le sue conoscenze tecnologiche e le sue capacità di scrittura, aiutando nel contempo a guidare gli altri.

Altro su questo argomento

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- EVM Finance. Interfaccia unificata per la finanza decentralizzata. Accedi qui.

- Quantum Media Group. IR/PR amplificato. Accedi qui.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.kdnuggets.com/2023/06/falcon-llm-new-king-llms.html?utm_source=rss&utm_medium=rss&utm_campaign=falcon-llm-the-new-king-of-open-source-llms

Falcon LLM: il nuovo re degli LLM open source – KDnuggets

Ripubblicato da Platone

Immagine dell'editore

Abbiamo visto grandi modelli linguistici (LLM) sputare fuori ogni settimana, con sempre più chatbot da utilizzare. Tuttavia, può essere difficile capire quale sia il migliore, i progressi su ciascuno e quale sia il più utile.

abbracciare il viso ha una classifica Open LLM che tiene traccia, valuta e classifica gli LLM man mano che vengono rilasciati. Usano un framework unico che viene utilizzato per testare modelli di linguaggio generativo su diversi compiti di valutazione.

Di recente, LLaMA (Large Language Model Meta AI) era in cima alla classifica ed è stato recentemente detronizzato da un nuovo LLM pre-addestrato: Falcon 40B.

Immagine di Classifica LLM aperta HuggingFace

Falco LLM è stata fondata e costruita dal Istituto per l'innovazione tecnologica (TII), una società che fa parte dell'Advanced Technology Research Council del governo di Abu Dhabi. Il governo sovrintende alla ricerca tecnologica in tutti gli Emirati Arabi Uniti, dove il team di scienziati, ricercatori e ingegneri si concentra sulla fornitura di tecnologie trasformative e scoperte scientifiche.

Falco-40B è un LLM fondamentale con parametri 40B, formazione su un trilione di token. Falcon 40B è un modello solo decoder autoregressivo. Un modello di solo decodificatore autoregressivo significa che il modello viene addestrato per prevedere il token successivo in una sequenza dati i token precedenti. Il modello GPT ne è un buon esempio.

L'architettura di Falcon ha dimostrato di superare in modo significativo GPT-3 solo per il 75% del budget di calcolo per l'addestramento, oltre a richiedere solo? del calcolo al momento dell'inferenza.

La qualità dei dati su larga scala è stata un obiettivo importante del team del Technology Innovation Institute, poiché sappiamo che gli LLM sono molto sensibili alla qualità dei dati di formazione. Il team ha creato una pipeline di dati scalabile fino a decine di migliaia di core della CPU per un'elaborazione rapida ed è stato in grado di estrarre contenuti di alta qualità dal Web utilizzando filtri e deduplicazione estesi.

Hanno anche un'altra versione più piccola: Falco-7B che ha parametri 7B, addestrati su token 1,500B. Così come un Falcon-40B-Istruzionee Falcon-7B-Istruzione modelli disponibili, se stai cercando un modello di chat pronto all'uso.

Cosa può fare Falcon 40B?

Simile ad altri LLM, Falcon 40B può:

Come è stato addestrato il Falcon 40B?

Essendo stato addestrato su 1 trilione di token, ha richiesto 384 GPU su AWS, in due mesi. Addestrato su 1,000 miliardi di token di Web raffinato, un enorme set di dati web in inglese creato da TII.

I dati di pre-formazione consistevano in una raccolta di dati pubblici dal web, utilizzando Scansione comune. Il team ha attraversato un'accurata fase di filtraggio per rimuovere il testo generato dalla macchina e il contenuto per adulti, nonché qualsiasi deduplicazione per produrre un set di dati di pre-addestramento di quasi cinque trilioni di token è stato assemblato.

Basato su CommonCrawl, il set di dati RefinedWeb ha dimostrato che i modelli ottengono prestazioni migliori rispetto ai modelli addestrati su set di dati curati. RefinedWeb è anche multimodale.

Una volta pronto, Falcon è stato convalidato rispetto a benchmark open source come EAI Harness, HELM e BigBench.

Hanno Falcon LLM open-source al pubblico, rendendo Falcon 40B e 7B più accessibili a ricercatori e sviluppatori poiché si basa sulla versione Apache License Version 2.0.

Il LLM, che una volta era solo per la ricerca e per uso commerciale, è ora diventato open-source per soddisfare la domanda globale di accesso inclusivo all'IA. Ora è privo di royalty per le restrizioni sull'uso commerciale, poiché gli Emirati Arabi Uniti sono impegnati a cambiare le sfide e i confini all'interno dell'IA e come svolge un ruolo significativo in futuro.

Con l'obiettivo di coltivare un ecosistema di collaborazione, innovazione e condivisione delle conoscenze nel mondo dell'intelligenza artificiale, Apache 2.0 garantisce sicurezza e sicurezza del software open source.

Se vuoi provare una versione più semplice di Falcon-40B che è più adatta per istruzioni generiche nello stile di un chatbot, devi usare Falcon-7B.

Quindi iniziamo…

Se non lo hai già fatto, installa i seguenti pacchetti:

Dopo aver installato questi pacchetti, puoi quindi passare all'esecuzione del codice previsto Falcon 7-B Istruire:

Rappresentando il miglior modello open source disponibile, Falcon ha conquistato la corona di LLaMA e le persone sono stupite dalla sua architettura fortemente ottimizzata, open source con una licenza unica ed è disponibile in due dimensioni: parametri 40B e 7B.

Hai provato? Se avete, fateci sapere nei commenti cosa ne pensate.

Nisha Aria è Data Scientist, Scrittore tecnico freelance e Community Manager presso KDnuggets. È particolarmente interessata a fornire consulenza o tutorial sulla carriera in Data Science e conoscenze basate sulla teoria in Data Science. Desidera anche esplorare i diversi modi in cui l'Intelligenza Artificiale è/può giovare alla longevità della vita umana. Una studentessa appassionata, che cerca di ampliare le sue conoscenze tecnologiche e le sue capacità di scrittura, aiutando nel contempo a guidare gli altri.

Altro su questo argomento

Fujitsu Japan adotta il provider di servizi cloud Alloy di Oracle

Il cyberattacco porta offline le comunicazioni di frontiera

Evil XDR: un ricercatore trasforma il software di Palo Alto in un malware perfetto

Meta lancia ufficialmente il suo chatbot AI basato su Llama 3

Yen, franco svizzero, petrolio e oro balzano sui timori di una guerra in Medio Oriente | Forexlive

I distretti dell'Indiana utilizzano le strutture e il supporto NIET per orientarsi nella scuola virtuale nei primi due anni di sovvenzione federale

Indicatore MA Rainbow MT4 - ForexMT4Indicators.com

Meta debutta con il modello linguistico grande Lama di terza generazione

La seconda stagione di Fallout è stata confermata, quindi portate avanti i Deathclaw

La coppia GBP/USD rimane sulla difensiva sotto 1.2450 in attesa dei dati sulle vendite al dettaglio nel Regno Unito