Bilde av redaktør

Vi har sett store språkmodeller (LLM) spytte ut hver uke, med flere og flere chatboter som vi kan bruke. Det kan imidlertid være vanskelig å finne ut hvilken som er best, fremgangen på hver og hvilken som er mest nyttig.

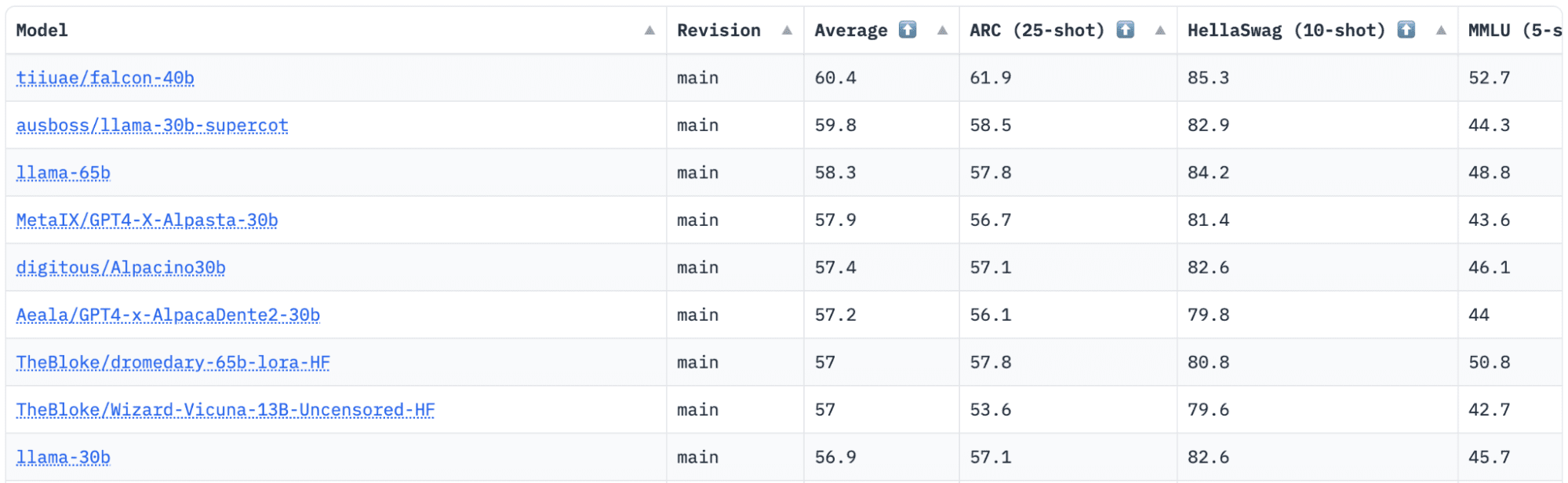

Klem ansikt har en Open LLM Leaderboard som sporer, evaluerer og rangerer LLM-er etter hvert som de blir utgitt. De bruker et unikt rammeverk som brukes til å teste generative språkmodeller på ulike evalueringsoppgaver.

Nylig var LLaMA (Large Language Model Meta AI) på toppen av ledertavlen og har nylig blitt detronisert av en ny forhåndsutdannet LLM – Falcon 40B.

Bilde av HuggingFace Open LLM Leaderboard

Falcon LLM ble grunnlagt og bygget av Institutt for teknologiinnovasjon (TII), et selskap som er en del av Abu Dhabi-regjeringens Advanced Technology Research Council. Regjeringen fører tilsyn med teknologiforskning i hele De forente arabiske emirater, hvor teamet av vitenskapsmenn, forskere og ingeniører fokuserer på å levere transformative teknologier og oppdagelser innen vitenskap.

Falcon-40B er en grunnleggende LLM med 40B parametere, trening på en billion tokens. Falcon 40B er en autoregressiv dekoder-modell. En autoregressiv dekodermodell betyr at modellen er trent til å forutsi neste token i en sekvens gitt de forrige tokenene. GPT-modellen er et godt eksempel på dette.

Arkitekturen til Falcon har vist seg å overgå GPT-3 betydelig for bare 75 % av treningsberegningsbudsjettet, i tillegg til at den bare krever ? av beregningen på slutningstidspunkt.

Datakvalitet i stor skala var et viktig fokus for teamet ved Technology Innovation Institute, siden vi vet at LLM-er er svært sensitive for kvaliteten på opplæringsdata. Teamet bygde en datapipeline som skalert til titusenvis av CPU-kjerner for rask prosessering og var i stand til å trekke ut høykvalitetsinnhold fra nettet ved hjelp av omfattende filtrering og deduplisering.

De har også en annen mindre versjon: Falcon-7B som har 7B parametere, trent på 1,500B tokens. Samt en Falcon-40B-Instrukog Falcon-7B-Instruk tilgjengelige modeller, hvis du leter etter en bruksklar chat-modell.

Hva kan Falcon 40B gjøre?

I likhet med andre LLM-er kan Falcon 40B:

- Generer kreativt innhold

- Løs komplekse problemer

- Kundeservicedrift

- Virtuelle assistenter

- Språk Oversettelse

- Sentimentanalyse.

- Reduser og automatiser "repetitivt" arbeid.

- Hjelp emiratiske selskaper med å bli mer effektive

Hvordan ble Falcon 40B trent?

Etter å ha blitt trent på 1 billion tokens, krevde det 384 GPUer på AWS, over to måneder. Trenet på 1,000B tokens av RefinedWeb, et massivt engelsk nettdatasett bygget av TII.

Foropplæringsdata besto av en innsamling av offentlige data fra nettet, vha CommonCrawl. Teamet gikk gjennom en grundig filtreringsfase for å fjerne maskingenerert tekst, og vokseninnhold samt eventuell deduplisering for å produsere et forhåndsopplæringsdatasett på nesten fem billioner tokens ble satt sammen.

RefinedWeb-datasettet er bygget på toppen av CommonCrawl, og har vist at modeller oppnår bedre ytelse enn modeller som er trent på kurerte datasett. RefinedWeb er også multimodalvennlig.

Når den var klar, ble Falcon validert mot åpen kildekode-referanser som EAI Harness, HELM og BigBench.

De har åpen kildekode Falcon LLM for publikum, noe som gjør Falcon 40B og 7B mer tilgjengelig for forskere og utviklere ettersom den er basert på Apache License versjon 2.0-utgivelsen.

LLM som en gang kun var for forskning og kommersiell bruk, har nå blitt åpen kildekode for å imøtekomme den globale etterspørselen etter inkluderende tilgang til AI. Den er nå fri for royalties for kommersiell bruksrestriksjoner, ettersom UAE er forpliktet til å endre utfordringene og grensene innen AI og hvordan det spiller en betydelig rolle i fremtiden.

Med sikte på å dyrke et økosystem av samarbeid, innovasjon og kunnskapsdeling i AI-verdenen, sikrer Apache 2.0 sikkerhet og sikker åpen kildekode-programvare.

Hvis du vil prøve ut en enklere versjon av Falcon-40B som er bedre egnet for generiske instruksjoner i stil med en chatbot, vil du bruke Falcon-7B.

Så la oss komme i gang ...

Hvis du ikke allerede har gjort det, installer følgende pakker:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Når du har installert disse pakkene, kan du gå videre til å kjøre den angitte koden Falcon 7-B Instruk:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Falcon står som den beste åpen kildekode-modellen tilgjengelig, og har tatt LLaMAs kronen, og folk er overrasket over dens sterkt optimaliserte arkitektur, åpen kildekode med en unik lisens, og den er tilgjengelig i to størrelser: 40B og 7B parametere.

Har du prøvd? Hvis du har, gi oss beskjed i kommentarene hva du synes.

Nisha Arya er dataforsker, frilans teknisk skribent og samfunnsansvarlig i KDnuggets. Hun er spesielt interessert i å gi Data Science karriereråd eller veiledninger og teoribasert kunnskap rundt Data Science. Hun ønsker også å utforske de forskjellige måtene kunstig intelligens er/kan være til nytte for menneskets levetid. En ivrig elev som søker å utvide sine tekniske kunnskaper og skriveferdigheter, samtidig som hun hjelper til med å veilede andre.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- EVM Finans. Unified Interface for desentralisert økonomi. Tilgang her.

- Quantum Media Group. IR/PR forsterket. Tilgang her.

- PlatoAiStream. Web3 Data Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.kdnuggets.com/2023/06/falcon-llm-new-king-llms.html?utm_source=rss&utm_medium=rss&utm_campaign=falcon-llm-the-new-king-of-open-source-llms

Falcon LLM: The New King of Open-Source LLMs – KDnuggets

Publisert av Platon

Bilde av redaktør

Vi har sett store språkmodeller (LLM) spytte ut hver uke, med flere og flere chatboter som vi kan bruke. Det kan imidlertid være vanskelig å finne ut hvilken som er best, fremgangen på hver og hvilken som er mest nyttig.

Klem ansikt har en Open LLM Leaderboard som sporer, evaluerer og rangerer LLM-er etter hvert som de blir utgitt. De bruker et unikt rammeverk som brukes til å teste generative språkmodeller på ulike evalueringsoppgaver.

Nylig var LLaMA (Large Language Model Meta AI) på toppen av ledertavlen og har nylig blitt detronisert av en ny forhåndsutdannet LLM – Falcon 40B.

Bilde av HuggingFace Open LLM Leaderboard

Falcon LLM ble grunnlagt og bygget av Institutt for teknologiinnovasjon (TII), et selskap som er en del av Abu Dhabi-regjeringens Advanced Technology Research Council. Regjeringen fører tilsyn med teknologiforskning i hele De forente arabiske emirater, hvor teamet av vitenskapsmenn, forskere og ingeniører fokuserer på å levere transformative teknologier og oppdagelser innen vitenskap.

Falcon-40B er en grunnleggende LLM med 40B parametere, trening på en billion tokens. Falcon 40B er en autoregressiv dekoder-modell. En autoregressiv dekodermodell betyr at modellen er trent til å forutsi neste token i en sekvens gitt de forrige tokenene. GPT-modellen er et godt eksempel på dette.

Arkitekturen til Falcon har vist seg å overgå GPT-3 betydelig for bare 75 % av treningsberegningsbudsjettet, i tillegg til at den bare krever ? av beregningen på slutningstidspunkt.

Datakvalitet i stor skala var et viktig fokus for teamet ved Technology Innovation Institute, siden vi vet at LLM-er er svært sensitive for kvaliteten på opplæringsdata. Teamet bygde en datapipeline som skalert til titusenvis av CPU-kjerner for rask prosessering og var i stand til å trekke ut høykvalitetsinnhold fra nettet ved hjelp av omfattende filtrering og deduplisering.

De har også en annen mindre versjon: Falcon-7B som har 7B parametere, trent på 1,500B tokens. Samt en Falcon-40B-Instrukog Falcon-7B-Instruk tilgjengelige modeller, hvis du leter etter en bruksklar chat-modell.

Hva kan Falcon 40B gjøre?

I likhet med andre LLM-er kan Falcon 40B:

Hvordan ble Falcon 40B trent?

Etter å ha blitt trent på 1 billion tokens, krevde det 384 GPUer på AWS, over to måneder. Trenet på 1,000B tokens av RefinedWeb, et massivt engelsk nettdatasett bygget av TII.

Foropplæringsdata besto av en innsamling av offentlige data fra nettet, vha CommonCrawl. Teamet gikk gjennom en grundig filtreringsfase for å fjerne maskingenerert tekst, og vokseninnhold samt eventuell deduplisering for å produsere et forhåndsopplæringsdatasett på nesten fem billioner tokens ble satt sammen.

RefinedWeb-datasettet er bygget på toppen av CommonCrawl, og har vist at modeller oppnår bedre ytelse enn modeller som er trent på kurerte datasett. RefinedWeb er også multimodalvennlig.

Når den var klar, ble Falcon validert mot åpen kildekode-referanser som EAI Harness, HELM og BigBench.

De har åpen kildekode Falcon LLM for publikum, noe som gjør Falcon 40B og 7B mer tilgjengelig for forskere og utviklere ettersom den er basert på Apache License versjon 2.0-utgivelsen.

LLM som en gang kun var for forskning og kommersiell bruk, har nå blitt åpen kildekode for å imøtekomme den globale etterspørselen etter inkluderende tilgang til AI. Den er nå fri for royalties for kommersiell bruksrestriksjoner, ettersom UAE er forpliktet til å endre utfordringene og grensene innen AI og hvordan det spiller en betydelig rolle i fremtiden.

Med sikte på å dyrke et økosystem av samarbeid, innovasjon og kunnskapsdeling i AI-verdenen, sikrer Apache 2.0 sikkerhet og sikker åpen kildekode-programvare.

Hvis du vil prøve ut en enklere versjon av Falcon-40B som er bedre egnet for generiske instruksjoner i stil med en chatbot, vil du bruke Falcon-7B.

Så la oss komme i gang ...

Hvis du ikke allerede har gjort det, installer følgende pakker:

Når du har installert disse pakkene, kan du gå videre til å kjøre den angitte koden Falcon 7-B Instruk:

Falcon står som den beste åpen kildekode-modellen tilgjengelig, og har tatt LLaMAs kronen, og folk er overrasket over dens sterkt optimaliserte arkitektur, åpen kildekode med en unik lisens, og den er tilgjengelig i to størrelser: 40B og 7B parametere.

Har du prøvd? Hvis du har, gi oss beskjed i kommentarene hva du synes.

Nisha Arya er dataforsker, frilans teknisk skribent og samfunnsansvarlig i KDnuggets. Hun er spesielt interessert i å gi Data Science karriereråd eller veiledninger og teoribasert kunnskap rundt Data Science. Hun ønsker også å utforske de forskjellige måtene kunstig intelligens er/kan være til nytte for menneskets levetid. En ivrig elev som søker å utvide sine tekniske kunnskaper og skriveferdigheter, samtidig som hun hjelper til med å veilede andre.

Mer om dette emnet

Could AI Have Prevented the Houston Metro Bus Incident?

Den nigerianske sentralbanken avviser brev som pålegger banker å bryte bånd med kryptobørser

My Career in Data Season 2 Episode 15: Kevin Cole, Director, Product and Technical Marketing, Zerto, a Hewlett Packard Enterprise Company – DATAVERSITY

Etihad avduker Airbus A380-tjeneste til Paris, og introduserer luksus flyopplevelse

Lithia tar 250 jobber, bilbutikker tar støyten

Brussel lufthavn ser etter 75 sikkerhetsvakter for å takle toppen i flytrafikken som forventes i sommer

Run interactive workloads on Amazon EMR Serverless from Amazon EMR Studio | Amazon Web Services

AI kan nå redigere menneskelig DNA!

Volkswagen ID.Code-konsept debuterer nytt stylingspråk for elektriske VW-er i Beijing