Obraz autorstwa redaktora

Widzieliśmy, jak co tydzień pojawiają się duże modele językowe (LLM), z coraz większą liczbą chatbotów, z których możemy korzystać. Jednak ustalenie, który jest najlepszy, postęp w każdym z nich i który jest najbardziej użyteczny, może być trudne.

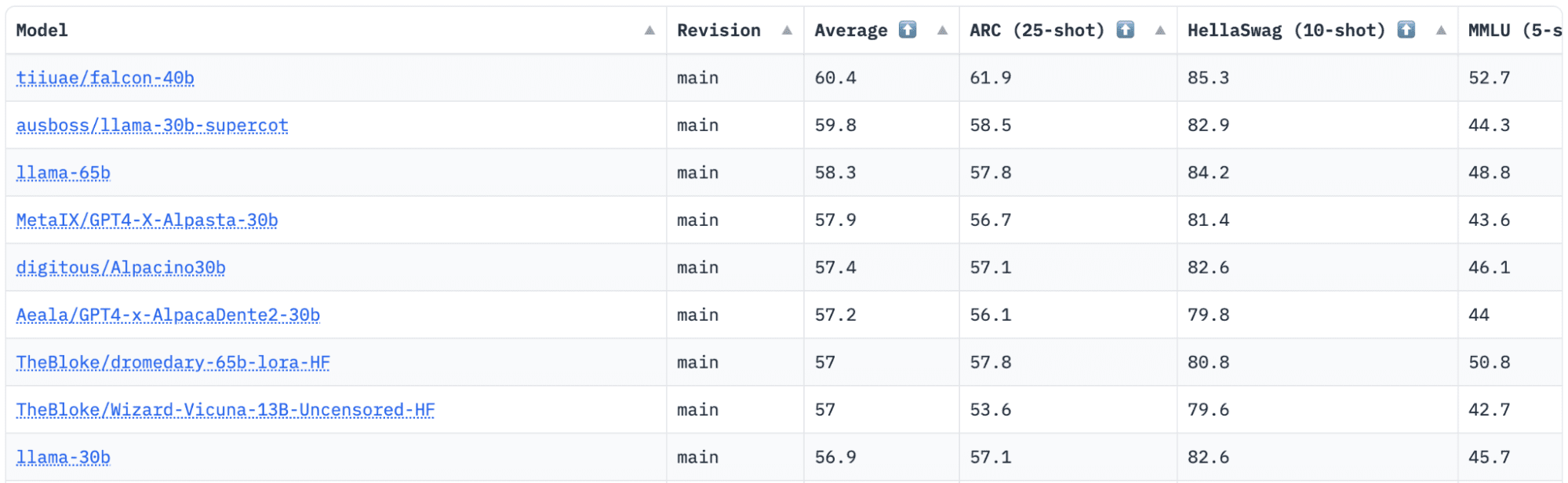

Przytulanie twarzy ma tablicę liderów Open LLM, która śledzi, ocenia i klasyfikuje LLM w miarę ich wydawania. Używają unikalnej struktury, która jest używana do testowania generatywnych modeli językowych w różnych zadaniach ewaluacyjnych.

Ostatnio LLaMA (Large Language Model Meta AI) znajdował się na szczycie tabeli liderów i został niedawno zdetronizowany przez nowy, wstępnie wyszkolony LLM – Falcon 40B.

Image by HuggingFace Otwarta tablica wyników LLM

Firma Falcon LLM została założona i zbudowana przez Instytut Innowacji Technologicznych (TII), firma będąca częścią Rady ds. Badań nad Zaawansowanymi Technologiami rządu Abu Zabi. Rząd nadzoruje badania technologiczne w całych Zjednoczonych Emiratach Arabskich, gdzie zespół naukowców, badaczy i inżynierów koncentruje się na dostarczaniu przełomowych technologii i odkryć naukowych.

Sokół-40B to podstawowy LLM z parametrami 40B, trenujący na jednym bilionie tokenów. Falcon 40B to model wyłącznie z dekoderem autoregresyjnym. Model autoregresyjny tylko z dekoderem oznacza, że model jest szkolony do przewidywania następnego tokena w sekwencji, biorąc pod uwagę poprzednie tokeny. Model GPT jest tego dobrym przykładem.

Wykazano, że architektura Falcon znacznie przewyższa GPT-3 przy zaledwie 75% budżetu obliczeniowego szkolenia, a także wymaga tylko ? obliczenia w czasie wnioskowania.

Jakość danych na dużą skalę była ważnym celem zespołu w Technology Innovation Institute, ponieważ wiemy, że LLM są bardzo wrażliwe na jakość danych szkoleniowych. Zespół zbudował potok danych, który skalował się do dziesiątek tysięcy rdzeni procesora w celu szybkiego przetwarzania i był w stanie wyodrębnić wysokiej jakości treści z sieci za pomocą rozbudowanego filtrowania i deduplikacji.

Mają też inną mniejszą wersję: Sokół-7B który ma 7B parametrów, wytrenowany na 1,500B tokenach. A także jako Instruktaż Falcon-40B, Instruktaż Falcon-7B dostępnych modeli, jeśli szukasz gotowego do użycia modelu czatu.

Co potrafi Falcon 40B?

Podobnie jak inne LLM, Falcon 40B może:

- Twórz kreatywne treści

- Rozwiązuj złożone problemy

- Operacje obsługi klienta

- Wirtualni asystenci

- Tłumaczenie językowe

- Analiza nastrojów.

- Zredukuj i zautomatyzuj „powtarzalną” pracę.

- Pomóż firmom z Emiratów zwiększyć wydajność

Jak szkolono Falcona 40B?

Przeszkolony na 1 bilionie tokenów wymagał 384 procesorów graficznych na AWS w ciągu dwóch miesięcy. Wyszkolony na tokenach 1,000B Wyrafinowana sieć, ogromny zestaw danych internetowych w języku angielskim zbudowany przez TII.

Dane wstępnego szkolenia składały się ze zbioru danych publicznych z sieci, przy użyciu Wspólne przeszukiwanie. Zespół przeszedł przez dokładną fazę filtrowania, aby usunąć tekst generowany maszynowo i treści dla dorosłych, a także wszelkie deduplikacje w celu utworzenia wstępnego zestawu danych zawierającego prawie pięć bilionów tokenów.

Zestaw danych RefinedWeb, zbudowany na bazie CommonCrawl, pokazał, że modele osiągają lepszą wydajność niż modele, które są szkolone na wyselekcjonowanych zestawach danych. RefinedWeb jest również przyjazny multimodalnie.

Gdy był gotowy, Falcon został zweryfikowany pod kątem testów porównawczych open source, takich jak EAI Harness, HELM i BigBench.

Mają Falcon LLM o otwartym kodzie źródłowym publicznie, dzięki czemu Falcon 40B i 7B są bardziej dostępne dla badaczy i programistów, ponieważ są oparte na licencji Apache w wersji 2.0.

LLM, który kiedyś służył wyłącznie do celów badawczych i komercyjnych, stał się teraz oprogramowaniem typu open source, aby zaspokoić globalne zapotrzebowanie na integracyjny dostęp do sztucznej inteligencji. Jest teraz wolny od opłat licencyjnych za ograniczenia dotyczące użytku komercyjnego, ponieważ Zjednoczone Emiraty Arabskie są zobowiązane do zmiany wyzwań i granic w ramach sztucznej inteligencji oraz tego, jak odgrywa ona znaczącą rolę w przyszłości.

Mając na celu kultywowanie ekosystemu współpracy, innowacji i dzielenia się wiedzą w świecie sztucznej inteligencji, Apache 2.0 zapewnia bezpieczeństwo i bezpieczne oprogramowanie typu open source.

Jeśli chcesz wypróbować prostszą wersję Falcon-40B, która lepiej nadaje się do ogólnych instrukcji w stylu chatbota, chcesz użyć Falcon-7B.

Więc zacznijmy…

Jeśli jeszcze tego nie zrobiłeś, zainstaluj następujące pakiety:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Po zainstalowaniu tych pakietów możesz przejść do uruchamiania przewidzianego kodu Instruktaż Falcona 7-B:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Będąc najlepszym dostępnym modelem open source, Falcon zdobył koronę LLaMA, a ludzie są zdumieni jego silnie zoptymalizowaną architekturą, open source z unikalną licencją i jest dostępny w dwóch rozmiarach: parametrach 40B i 7B.

Czy próbowałeś? Jeśli tak, daj nam znać w komentarzach, co myślisz.

Nisza Arja jest analitykiem danych, niezależnym pisarzem technicznym i menedżerem ds. społeczności w KDnuggets. Jest szczególnie zainteresowana udzielaniem porad dotyczących kariery w Data Science lub samouczkami i wiedzą opartą na teorii wokół Data Science. Chciałaby również zbadać różne sposoby, w jakie sztuczna inteligencja jest / może korzystnie wpłynąć na długowieczność ludzkiego życia. Chętnie się uczy, stara się poszerzyć swoją wiedzę techniczną i umiejętności pisania, jednocześnie pomagając innym.

Falcon LLM: nowy król LLM typu open source – KDnuggets

Opublikowane ponownie przez Plato

Obraz autorstwa redaktora

Widzieliśmy, jak co tydzień pojawiają się duże modele językowe (LLM), z coraz większą liczbą chatbotów, z których możemy korzystać. Jednak ustalenie, który jest najlepszy, postęp w każdym z nich i który jest najbardziej użyteczny, może być trudne.

Przytulanie twarzy ma tablicę liderów Open LLM, która śledzi, ocenia i klasyfikuje LLM w miarę ich wydawania. Używają unikalnej struktury, która jest używana do testowania generatywnych modeli językowych w różnych zadaniach ewaluacyjnych.

Ostatnio LLaMA (Large Language Model Meta AI) znajdował się na szczycie tabeli liderów i został niedawno zdetronizowany przez nowy, wstępnie wyszkolony LLM – Falcon 40B.

Image by HuggingFace Otwarta tablica wyników LLM

Firma Falcon LLM została założona i zbudowana przez Instytut Innowacji Technologicznych (TII), firma będąca częścią Rady ds. Badań nad Zaawansowanymi Technologiami rządu Abu Zabi. Rząd nadzoruje badania technologiczne w całych Zjednoczonych Emiratach Arabskich, gdzie zespół naukowców, badaczy i inżynierów koncentruje się na dostarczaniu przełomowych technologii i odkryć naukowych.

Sokół-40B to podstawowy LLM z parametrami 40B, trenujący na jednym bilionie tokenów. Falcon 40B to model wyłącznie z dekoderem autoregresyjnym. Model autoregresyjny tylko z dekoderem oznacza, że model jest szkolony do przewidywania następnego tokena w sekwencji, biorąc pod uwagę poprzednie tokeny. Model GPT jest tego dobrym przykładem.

Wykazano, że architektura Falcon znacznie przewyższa GPT-3 przy zaledwie 75% budżetu obliczeniowego szkolenia, a także wymaga tylko ? obliczenia w czasie wnioskowania.

Jakość danych na dużą skalę była ważnym celem zespołu w Technology Innovation Institute, ponieważ wiemy, że LLM są bardzo wrażliwe na jakość danych szkoleniowych. Zespół zbudował potok danych, który skalował się do dziesiątek tysięcy rdzeni procesora w celu szybkiego przetwarzania i był w stanie wyodrębnić wysokiej jakości treści z sieci za pomocą rozbudowanego filtrowania i deduplikacji.

Mają też inną mniejszą wersję: Sokół-7B który ma 7B parametrów, wytrenowany na 1,500B tokenach. A także jako Instruktaż Falcon-40B, Instruktaż Falcon-7B dostępnych modeli, jeśli szukasz gotowego do użycia modelu czatu.

Co potrafi Falcon 40B?

Podobnie jak inne LLM, Falcon 40B może:

Jak szkolono Falcona 40B?

Przeszkolony na 1 bilionie tokenów wymagał 384 procesorów graficznych na AWS w ciągu dwóch miesięcy. Wyszkolony na tokenach 1,000B Wyrafinowana sieć, ogromny zestaw danych internetowych w języku angielskim zbudowany przez TII.

Dane wstępnego szkolenia składały się ze zbioru danych publicznych z sieci, przy użyciu Wspólne przeszukiwanie. Zespół przeszedł przez dokładną fazę filtrowania, aby usunąć tekst generowany maszynowo i treści dla dorosłych, a także wszelkie deduplikacje w celu utworzenia wstępnego zestawu danych zawierającego prawie pięć bilionów tokenów.

Zestaw danych RefinedWeb, zbudowany na bazie CommonCrawl, pokazał, że modele osiągają lepszą wydajność niż modele, które są szkolone na wyselekcjonowanych zestawach danych. RefinedWeb jest również przyjazny multimodalnie.

Gdy był gotowy, Falcon został zweryfikowany pod kątem testów porównawczych open source, takich jak EAI Harness, HELM i BigBench.

Mają Falcon LLM o otwartym kodzie źródłowym publicznie, dzięki czemu Falcon 40B i 7B są bardziej dostępne dla badaczy i programistów, ponieważ są oparte na licencji Apache w wersji 2.0.

LLM, który kiedyś służył wyłącznie do celów badawczych i komercyjnych, stał się teraz oprogramowaniem typu open source, aby zaspokoić globalne zapotrzebowanie na integracyjny dostęp do sztucznej inteligencji. Jest teraz wolny od opłat licencyjnych za ograniczenia dotyczące użytku komercyjnego, ponieważ Zjednoczone Emiraty Arabskie są zobowiązane do zmiany wyzwań i granic w ramach sztucznej inteligencji oraz tego, jak odgrywa ona znaczącą rolę w przyszłości.

Mając na celu kultywowanie ekosystemu współpracy, innowacji i dzielenia się wiedzą w świecie sztucznej inteligencji, Apache 2.0 zapewnia bezpieczeństwo i bezpieczne oprogramowanie typu open source.

Jeśli chcesz wypróbować prostszą wersję Falcon-40B, która lepiej nadaje się do ogólnych instrukcji w stylu chatbota, chcesz użyć Falcon-7B.

Więc zacznijmy…

Jeśli jeszcze tego nie zrobiłeś, zainstaluj następujące pakiety:

Po zainstalowaniu tych pakietów możesz przejść do uruchamiania przewidzianego kodu Instruktaż Falcona 7-B:

Będąc najlepszym dostępnym modelem open source, Falcon zdobył koronę LLaMA, a ludzie są zdumieni jego silnie zoptymalizowaną architekturą, open source z unikalną licencją i jest dostępny w dwóch rozmiarach: parametrach 40B i 7B.

Czy próbowałeś? Jeśli tak, daj nam znać w komentarzach, co myślisz.

Nisza Arja jest analitykiem danych, niezależnym pisarzem technicznym i menedżerem ds. społeczności w KDnuggets. Jest szczególnie zainteresowana udzielaniem porad dotyczących kariery w Data Science lub samouczkami i wiedzą opartą na teorii wokół Data Science. Chciałaby również zbadać różne sposoby, w jakie sztuczna inteligencja jest / może korzystnie wpłynąć na długowieczność ludzkiego życia. Chętnie się uczy, stara się poszerzyć swoją wiedzę techniczną i umiejętności pisania, jednocześnie pomagając innym.

Więcej na ten temat

🔴 Bitcoin w pierwszej dziesiątce | W tym tygodniu w Crypto – 10 marca 4 r

Moment Factory wykorzystuje technologie nowej generacji Sphere, aby na nowo wyobrazić sobie wrażenia z koncertów

Lando Norris zdobywa pole position do sprinterskiego Grand Prix Chin F1 od Hamilton – Autoblog

„Portugalia rozpoczęła już przechodzenie na F-35” – mówi szef portugalskich sił powietrznych

Handlarz kryptowalutami skazany za oszustwo polegające na wykorzystaniu 110 milionów dolarów na rynkach Mango – CryptoInfoNet

Pionier Bitcoina Hal Finney pośmiertnie zdobywa nową nagrodę nazwaną jego imieniem

Webinarium RWDG: Wpływ zarządzania metadanymi na zarządzanie danymi – DATAVERSITY

Wiodąca giełda kryptowalut Bitalplus, dziedziczenie zaufania i postępu