Imagem do editor

Temos visto grandes modelos de linguagem (LLMs) sendo lançados todas as semanas, com cada vez mais chatbots para usarmos. No entanto, pode ser difícil descobrir qual é o melhor, o progresso de cada um e qual é o mais útil.

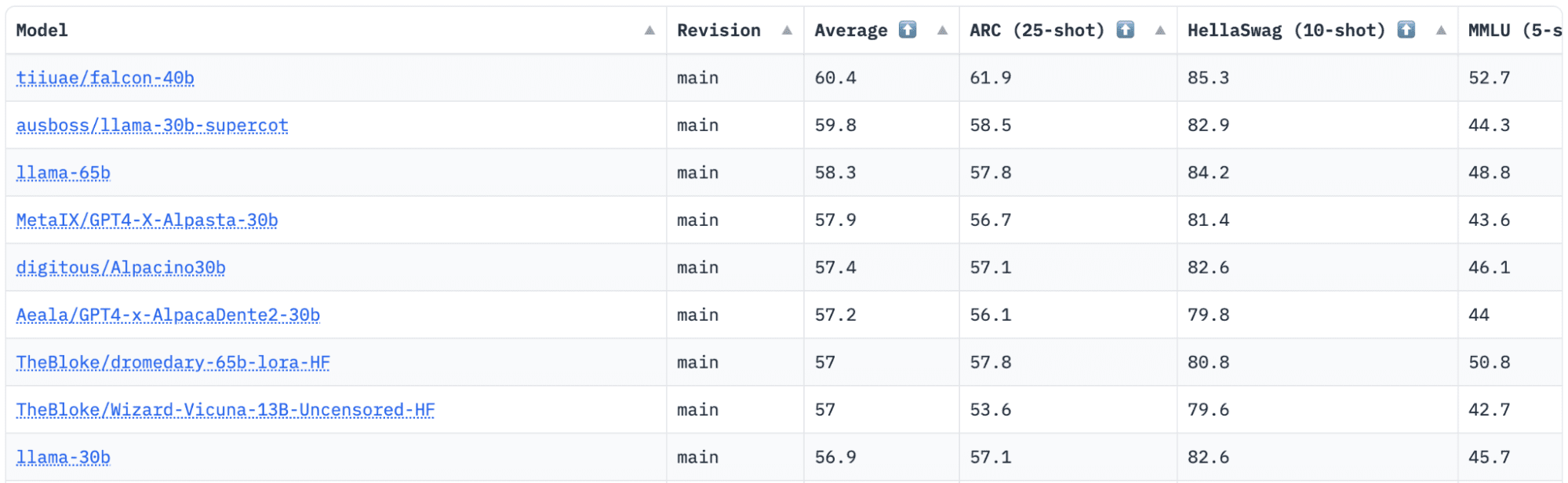

Abraçando o Rosto tem um Open LLM Leaderboard que rastreia, avalia e classifica os LLMs à medida que são lançados. Eles usam uma estrutura única que é usada para testar modelos de linguagem generativos em diferentes tarefas de avaliação.

Recentemente, o LLaMA (Large Language Model Meta AI) estava no topo da tabela de classificação e foi recentemente destronado por um novo LLM pré-treinado – Falcon 40B.

Imagem por Tabela de classificação HuggingFace Open LLM

Falcão LLM foi fundada e construída pelo Instituto de Inovação Tecnológica (TII), empresa que faz parte do Conselho de Pesquisa de Tecnologia Avançada do Governo de Abu Dhabi. O governo supervisiona a investigação tecnológica em todos os Emirados Árabes Unidos, onde a equipa de cientistas, investigadores e engenheiros se concentra no fornecimento de tecnologias e descobertas transformadoras na ciência.

Falcão-40B é um LLM básico com parâmetros de 40B, treinando em um trilhão de tokens. Falcon 40B é um modelo somente de decodificador autorregressivo. Um modelo somente decodificador autorregressivo significa que o modelo é treinado para prever o próximo token em uma sequência, dados os tokens anteriores. O modelo GPT é um bom exemplo disso.

Foi demonstrado que a arquitetura do Falcon supera significativamente o GPT-3 em apenas 75% do orçamento de computação para treinamento, além de exigir apenas ? do cálculo no momento da inferência.

A qualidade dos dados em escala foi um foco importante da equipe do Technology Innovation Institute, pois sabemos que os LLMs são altamente sensíveis à qualidade dos dados de treinamento. A equipe construiu um pipeline de dados que foi dimensionado para dezenas de milhares de núcleos de CPU para processamento rápido e foi capaz de extrair conteúdo de alta qualidade da web usando filtragem e desduplicação extensivas.

Eles também têm outra versão menor: Falcão-7B que possui 7B de parâmetros, treinado em 1,500B de tokens. Bem como um Falcon-40B-Instrução e Falcon-7B-Instrução modelos disponíveis, se você estiver procurando um modelo de chat pronto para usar.

O que o Falcon 40B pode fazer?

Semelhante a outros LLMs, o Falcon 40B pode:

- Gere conteúdo criativo

- Resolver problemas complexos

- Operações de atendimento ao cliente

- Assistentes virtuais

- Tradução de Línguas

- Análise de sentimentos.

- Reduza e automatize o trabalho “repetitivo”.

- Ajude as empresas dos Emirados a se tornarem mais eficientes

Como o Falcon 40B foi treinado?

Sendo treinado em 1 trilhão de tokens, foram necessários 384 GPUs na AWS, durante dois meses. Treinado em 1,000 bilhões de tokens de RefinadoWeb, um enorme conjunto de dados da web em inglês criado pela TII.

Os dados de pré-treinamento consistiram em uma coleta de dados públicos da web, usando Rastreamento comum. A equipe passou por uma fase de filtragem completa para remover texto gerado por máquina e conteúdo adulto, bem como qualquer desduplicação para produzir um conjunto de dados de pré-treinamento de quase cinco trilhões de tokens.

Construído com base no CommonCrawl, o conjunto de dados RefinedWeb mostrou que os modelos alcançam um desempenho melhor do que os modelos treinados em conjuntos de dados selecionados. RefinedWeb também é compatível com multimodais.

Depois de pronto, o Falcon foi validado em relação a benchmarks de código aberto, como EAI Harness, HELM e BigBench.

Eles têm Falcon LLM de código aberto ao público, tornando o Falcon 40B e 7B mais acessível a pesquisadores e desenvolvedores, pois é baseado na versão 2.0 da licença Apache.

O LLM, que antes era apenas para pesquisa e uso comercial, tornou-se agora de código aberto para atender à demanda global por acesso inclusivo à IA. Está agora livre de royalties para restrições de utilização comercial, uma vez que os EAU estão empenhados em mudar os desafios e limites dentro da IA e como esta desempenha um papel significativo no futuro.

Com o objetivo de cultivar um ecossistema de colaboração, inovação e compartilhamento de conhecimento no mundo da IA, o Apache 2.0 garante segurança e software de código aberto seguro.

Se você quiser experimentar uma versão mais simples do Falcon-40B, que seja mais adequada para instruções genéricas no estilo de um chatbot, você vai querer usar o Falcon-7B.

Então vamos começar…

Se ainda não o fez, instale os seguintes pacotes:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Depois de instalar esses pacotes, você poderá prosseguir para a execução do código fornecido para Instrução do Falcon 7-B:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Apresentando-se como o melhor modelo de código aberto disponível, o Falcon conquistou a coroa dos LLaMAs, e as pessoas ficam maravilhadas com sua arquitetura fortemente otimizada, de código aberto com licença exclusiva, e está disponível em dois tamanhos: parâmetros 40B e 7B.

Você já tentou? Se sim, deixe-nos saber nos comentários o que você pensa.

Nisha Arya é cientista de dados, redator técnico freelancer e gerente de comunidade da KDnuggets. Ela está particularmente interessada em fornecer conselhos ou tutoriais de carreira em Ciência de Dados e conhecimento baseado em teoria sobre Ciência de Dados. Ela também deseja explorar as diferentes maneiras pelas quais a Inteligência Artificial é/pode beneficiar a longevidade da vida humana. Uma aluna interessada, buscando ampliar seus conhecimentos técnicos e habilidades de escrita, ao mesmo tempo em que ajuda a orientar outras pessoas.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- EVM Finanças. Interface unificada para finanças descentralizadas. Acesse aqui.

- Grupo de Mídia Quântica. IR/PR Amplificado. Acesse aqui.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Fonte: https://www.kdnuggets.com/2023/06/falcon-llm-new-king-llms.html?utm_source=rss&utm_medium=rss&utm_campaign=falcon-llm-the-new-king-of-open-source-llms

Falcon LLM: O novo rei dos LLMs de código aberto – KDnuggets

Republicado por Platão

Imagem do editor

Temos visto grandes modelos de linguagem (LLMs) sendo lançados todas as semanas, com cada vez mais chatbots para usarmos. No entanto, pode ser difícil descobrir qual é o melhor, o progresso de cada um e qual é o mais útil.

Abraçando o Rosto tem um Open LLM Leaderboard que rastreia, avalia e classifica os LLMs à medida que são lançados. Eles usam uma estrutura única que é usada para testar modelos de linguagem generativos em diferentes tarefas de avaliação.

Recentemente, o LLaMA (Large Language Model Meta AI) estava no topo da tabela de classificação e foi recentemente destronado por um novo LLM pré-treinado – Falcon 40B.

Imagem por Tabela de classificação HuggingFace Open LLM

Falcão LLM foi fundada e construída pelo Instituto de Inovação Tecnológica (TII), empresa que faz parte do Conselho de Pesquisa de Tecnologia Avançada do Governo de Abu Dhabi. O governo supervisiona a investigação tecnológica em todos os Emirados Árabes Unidos, onde a equipa de cientistas, investigadores e engenheiros se concentra no fornecimento de tecnologias e descobertas transformadoras na ciência.

Falcão-40B é um LLM básico com parâmetros de 40B, treinando em um trilhão de tokens. Falcon 40B é um modelo somente de decodificador autorregressivo. Um modelo somente decodificador autorregressivo significa que o modelo é treinado para prever o próximo token em uma sequência, dados os tokens anteriores. O modelo GPT é um bom exemplo disso.

Foi demonstrado que a arquitetura do Falcon supera significativamente o GPT-3 em apenas 75% do orçamento de computação para treinamento, além de exigir apenas ? do cálculo no momento da inferência.

A qualidade dos dados em escala foi um foco importante da equipe do Technology Innovation Institute, pois sabemos que os LLMs são altamente sensíveis à qualidade dos dados de treinamento. A equipe construiu um pipeline de dados que foi dimensionado para dezenas de milhares de núcleos de CPU para processamento rápido e foi capaz de extrair conteúdo de alta qualidade da web usando filtragem e desduplicação extensivas.

Eles também têm outra versão menor: Falcão-7B que possui 7B de parâmetros, treinado em 1,500B de tokens. Bem como um Falcon-40B-Instrução e Falcon-7B-Instrução modelos disponíveis, se você estiver procurando um modelo de chat pronto para usar.

O que o Falcon 40B pode fazer?

Semelhante a outros LLMs, o Falcon 40B pode:

Como o Falcon 40B foi treinado?

Sendo treinado em 1 trilhão de tokens, foram necessários 384 GPUs na AWS, durante dois meses. Treinado em 1,000 bilhões de tokens de RefinadoWeb, um enorme conjunto de dados da web em inglês criado pela TII.

Os dados de pré-treinamento consistiram em uma coleta de dados públicos da web, usando Rastreamento comum. A equipe passou por uma fase de filtragem completa para remover texto gerado por máquina e conteúdo adulto, bem como qualquer desduplicação para produzir um conjunto de dados de pré-treinamento de quase cinco trilhões de tokens.

Construído com base no CommonCrawl, o conjunto de dados RefinedWeb mostrou que os modelos alcançam um desempenho melhor do que os modelos treinados em conjuntos de dados selecionados. RefinedWeb também é compatível com multimodais.

Depois de pronto, o Falcon foi validado em relação a benchmarks de código aberto, como EAI Harness, HELM e BigBench.

Eles têm Falcon LLM de código aberto ao público, tornando o Falcon 40B e 7B mais acessível a pesquisadores e desenvolvedores, pois é baseado na versão 2.0 da licença Apache.

O LLM, que antes era apenas para pesquisa e uso comercial, tornou-se agora de código aberto para atender à demanda global por acesso inclusivo à IA. Está agora livre de royalties para restrições de utilização comercial, uma vez que os EAU estão empenhados em mudar os desafios e limites dentro da IA e como esta desempenha um papel significativo no futuro.

Com o objetivo de cultivar um ecossistema de colaboração, inovação e compartilhamento de conhecimento no mundo da IA, o Apache 2.0 garante segurança e software de código aberto seguro.

Se você quiser experimentar uma versão mais simples do Falcon-40B, que seja mais adequada para instruções genéricas no estilo de um chatbot, você vai querer usar o Falcon-7B.

Então vamos começar…

Se ainda não o fez, instale os seguintes pacotes:

Depois de instalar esses pacotes, você poderá prosseguir para a execução do código fornecido para Instrução do Falcon 7-B:

Apresentando-se como o melhor modelo de código aberto disponível, o Falcon conquistou a coroa dos LLaMAs, e as pessoas ficam maravilhadas com sua arquitetura fortemente otimizada, de código aberto com licença exclusiva, e está disponível em dois tamanhos: parâmetros 40B e 7B.

Você já tentou? Se sim, deixe-nos saber nos comentários o que você pensa.

Nisha Arya é cientista de dados, redator técnico freelancer e gerente de comunidade da KDnuggets. Ela está particularmente interessada em fornecer conselhos ou tutoriais de carreira em Ciência de Dados e conhecimento baseado em teoria sobre Ciência de Dados. Ela também deseja explorar as diferentes maneiras pelas quais a Inteligência Artificial é/pode beneficiar a longevidade da vida humana. Uma aluna interessada, buscando ampliar seus conhecimentos técnicos e habilidades de escrita, ao mesmo tempo em que ajuda a orientar outras pessoas.

Mais sobre este tópico

Strayed é um jogo de sobrevivência multijogador VR inspirado na ferrugem no Quest e Steam

Reconciliação de caixa pequeno: melhores práticas e automação

SMC anuncia acordo de marketing com Plato Technologies. Inc.

Fraqueza do Windows 'MagicDot' permite atividade de rootkit sem privilégios

O poder das visualizações no YouTube: uma chave para o domínio na plataforma

Bonk e Pepe veem crescimento altista à medida que a nova moeda Meme está prestes a explodir

A conta corrente da Grécia (anual) caiu para -3.161 bilhões de euros em fevereiro, em relação aos 1.703 bilhões de euros anteriores

Conheça os oradores do nosso painel de discussão “Startups vs. Política: Como impulsionar ecossistemas de startups” na Cimeira UE-Startups deste ano | Startups da UE

Sindicatos do Reino Unido publicam projeto de lei sobre IA para proteger trabalhadores de “riscos”

Fujitsu Japão adota nuvem de provedor de serviços Alloy da Oracle