รูปภาพโดยบรรณาธิการ

เราได้เห็นโมเดลภาษาขนาดใหญ่ (LLM) ออกมาทุกสัปดาห์ โดยมีแชทบอทให้เราใช้เพิ่มมากขึ้นเรื่อยๆ อย่างไรก็ตาม อาจเป็นเรื่องยากที่จะพิจารณาว่าอันไหนดีที่สุด ความคืบหน้าในแต่ละอัน และอันไหนมีประโยชน์มากที่สุด

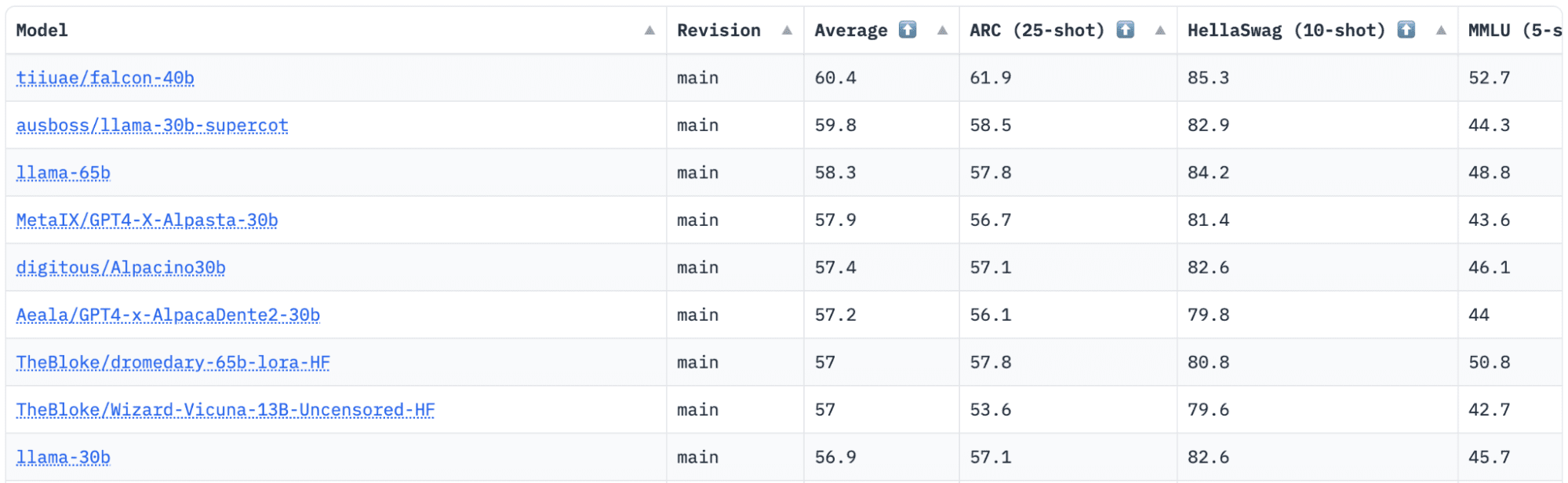

กอดใบหน้า มีกระดานผู้นำ Open LLM ซึ่งติดตาม ประเมิน และจัดอันดับ LLM เมื่อมีการเปิดตัว พวกเขาใช้กรอบงานที่เป็นเอกลักษณ์ซึ่งใช้ในการทดสอบแบบจำลองภาษาเชิงสร้างสรรค์ในงานประเมินผลที่แตกต่างกัน

ล่าสุด LLaMA (Large Language Model Meta AI) อยู่ในอันดับต้นๆ ของกระดานผู้นำ และเพิ่งถูกโค่นล้มโดย LLM ใหม่ที่ได้รับการฝึกล่วงหน้าอย่าง Falcon 40B

ภาพโดย กระดานผู้นำ HuggingFace Open LLM

ฟอลคอน แอลแอลเอ็ม ถูกก่อตั้งและสร้างโดย. สถาบันนวัตกรรมเทคโนโลยี (TII) ซึ่งเป็นบริษัทที่เป็นส่วนหนึ่งของสภาวิจัยเทคโนโลยีขั้นสูงของรัฐบาลอาบูดาบี รัฐบาลดูแลการวิจัยเทคโนโลยีทั่วทั้งสหรัฐอาหรับเอมิเรตส์ ซึ่งทีมนักวิทยาศาสตร์ นักวิจัย และวิศวกรมุ่งเน้นไปที่การนำเสนอเทคโนโลยีที่เปลี่ยนแปลงและการค้นพบทางวิทยาศาสตร์

ฟอลคอน-40บี เป็น LLM พื้นฐานที่มีพารามิเตอร์ 40B ฝึกอบรมเกี่ยวกับโทเค็นหนึ่งล้านล้านโทเค็น Falcon 40B เป็นรุ่นถอดรหัสอัตโนมัติเท่านั้น โมเดลเฉพาะตัวถอดรหัสแบบ autoregressive หมายความว่าโมเดลนั้นได้รับการฝึกฝนให้ทำนายโทเค็นถัดไปตามลำดับที่กำหนดให้กับโทเค็นก่อนหน้า โมเดล GPT เป็นตัวอย่างที่ดีของสิ่งนี้

สถาปัตยกรรมของ Falcon ได้รับการแสดงให้เห็นว่ามีประสิทธิภาพเหนือกว่า GPT-3 อย่างมากด้วยงบประมาณการประมวลผลการฝึกอบรมเพียง 75% เท่านั้น และต้องการเพียง ? ของการคำนวณในเวลาอนุมาน

คุณภาพข้อมูลตามขนาดเป็นจุดสนใจที่สำคัญของทีมที่ Technology Innovation Institute เนื่องจากเรารู้ว่า LLM มีความอ่อนไหวสูงต่อคุณภาพของข้อมูลการฝึกอบรม ทีมงานสร้างไปป์ไลน์ข้อมูลซึ่งปรับขนาดเป็นคอร์ CPU นับหมื่นเพื่อการประมวลผลที่รวดเร็ว และสามารถดึงเนื้อหาคุณภาพสูงจากเว็บโดยใช้การกรองและการขจัดข้อมูลซ้ำซ้อนที่ครอบคลุม

พวกเขายังมีอีกรุ่นที่เล็กกว่า: ฟอลคอน-7บี ซึ่งมีพารามิเตอร์ 7B ฝึกฝนกับโทเค็น 1,500B เช่นเดียวกับก Falcon-40B-คำสั่งและ Falcon-7B-คำสั่ง มีโมเดลให้เลือกหากคุณกำลังมองหาโมเดลแชทที่พร้อมใช้งาน

Falcon 40B ทำอะไรได้บ้าง?

เช่นเดียวกับ LLM อื่นๆ Falcon 40B สามารถ:

- สร้างเนื้อหาที่สร้างสรรค์

- แก้ไขปัญหาที่ซับซ้อน

- การดำเนินงานบริการลูกค้า

- ผู้ช่วยเสมือน

- การแปลภาษา

- การวิเคราะห์ความรู้สึก

- ลดและทำให้งาน "ซ้ำซาก" เป็นอัตโนมัติ

- ช่วยให้บริษัทในเอมิเรตส์มีประสิทธิภาพมากขึ้น

Falcon 40B ได้รับการฝึกฝนอย่างไร

ด้วยการฝึกอบรมบนโทเค็น 1 ล้านล้านโทเค็น ต้องใช้ GPU 384 ตัวบน AWS เป็นเวลากว่าสองเดือน ฝึกฝนด้วยโทเค็น 1,000B กลั่นเว็บซึ่งเป็นชุดข้อมูลเว็บภาษาอังกฤษขนาดใหญ่ที่สร้างโดย TII

ข้อมูลก่อนการฝึกอบรมประกอบด้วยการรวบรวมข้อมูลสาธารณะจากเว็บที่ใช้ CommonCrawl. ทีมงานได้ผ่านขั้นตอนการกรองอย่างละเอียดเพื่อลบข้อความที่เครื่องสร้างขึ้น และเนื้อหาสำหรับผู้ใหญ่ตลอดจนการขจัดข้อมูลซ้ำซ้อนเพื่อสร้างชุดข้อมูลการฝึกอบรมล่วงหน้าที่มีโทเค็นเกือบห้าล้านล้านโทเค็นได้ถูกรวบรวมไว้

ชุดข้อมูล RefinedWeb ที่สร้างขึ้นบน CommonCrawl ได้แสดงโมเดลเพื่อให้ได้ประสิทธิภาพที่ดีกว่าโมเดลที่ได้รับการฝึกบนชุดข้อมูลที่ได้รับการดูแลจัดการ RefinedWeb ยังเป็นมิตรกับหลายรูปแบบอีกด้วย

เมื่อพร้อมแล้ว Falcon จะได้รับการตรวจสอบเทียบกับการวัดประสิทธิภาพแบบโอเพ่นซอร์ส เช่น EAI Harness, HELM และ BigBench

พวกเขามี Falcon LLM แบบโอเพ่นซอร์ส สู่สาธารณะ ทำให้ Falcon 40B และ 7B เข้าถึงได้มากขึ้นสำหรับนักวิจัยและนักพัฒนา เนื่องจากเป็นไปตามการเปิดตัว Apache License เวอร์ชัน 2.0

LLM ซึ่งครั้งหนึ่งเคยมีไว้เพื่อการวิจัยและเชิงพาณิชย์เท่านั้น บัดนี้ได้กลายเป็นโอเพ่นซอร์สเพื่อตอบสนองความต้องการทั่วโลกในการเข้าถึง AI อย่างครอบคลุม ขณะนี้ไม่มีค่าลิขสิทธิ์สำหรับข้อจำกัดการใช้งานเชิงพาณิชย์ เนื่องจากสหรัฐอาหรับเอมิเรตส์มุ่งมั่นที่จะเปลี่ยนแปลงความท้าทายและขอบเขตภายใน AI และวิธีที่ AI จะมีบทบาทสำคัญในอนาคต

Apache 2.0 มุ่งมั่นที่จะปลูกฝังระบบนิเวศของการทำงานร่วมกัน นวัตกรรม และการแบ่งปันความรู้ในโลกของ AI รับประกันความปลอดภัยและซอฟต์แวร์โอเพ่นซอร์สที่ปลอดภัย

หากคุณต้องการลองใช้ Falcon-40B เวอร์ชันที่เรียบง่ายกว่า ซึ่งเหมาะกับคำสั่งทั่วไปในรูปแบบของแชทบอตมากกว่า คุณจะต้องใช้ Falcon-7B

มาเริ่มกันเลย…

หากคุณยังไม่ได้ติดตั้งแพ็คเกจต่อไปนี้:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

เมื่อคุณติดตั้งแพ็คเกจเหล่านี้แล้ว คุณสามารถไปยังการรันโค้ดที่ให้ไว้ได้ คำแนะนำเหยี่ยว 7-B:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Falcon ถือเป็นโมเดลโอเพ่นซอร์สที่ดีที่สุดและครองตำแหน่ง LLaMAs และผู้คนต่างประหลาดใจกับสถาปัตยกรรมที่ได้รับการปรับให้เหมาะสมที่สุด เป็นโอเพ่นซอร์สพร้อมลิขสิทธิ์เฉพาะตัว และมีจำหน่ายในสองขนาด: พารามิเตอร์ 40B และ 7B

คุณได้ลอง? หากคุณมีโปรดแจ้งให้เราทราบในความคิดเห็นว่าคุณคิดอย่างไร

ณิชา อารยา เป็นนักวิทยาศาสตร์ข้อมูล นักเขียนด้านเทคนิคอิสระ และผู้จัดการชุมชนที่ KDnuggets เธอสนใจเป็นพิเศษในการให้คำแนะนำด้านอาชีพของ Data Science หรือแบบฝึกหัดและความรู้ตามทฤษฎีเกี่ยวกับ Data Science นอกจากนี้ เธอยังต้องการสำรวจวิธีการต่างๆ ของปัญญาประดิษฐ์ที่สามารถเป็นประโยชน์ต่อการมีอายุยืนยาวของมนุษย์ ใฝ่เรียนรู้ ต้องการเพิ่มพูนความรู้ด้านเทคโนโลยีและทักษะการเขียน ในขณะที่ช่วยแนะนำผู้อื่น

Falcon LLM: ราชาองค์ใหม่ของ LLM แบบโอเพ่นซอร์ส – KDnuggets

เผยแพร่ซ้ำโดยเพลโต

รูปภาพโดยบรรณาธิการ

เราได้เห็นโมเดลภาษาขนาดใหญ่ (LLM) ออกมาทุกสัปดาห์ โดยมีแชทบอทให้เราใช้เพิ่มมากขึ้นเรื่อยๆ อย่างไรก็ตาม อาจเป็นเรื่องยากที่จะพิจารณาว่าอันไหนดีที่สุด ความคืบหน้าในแต่ละอัน และอันไหนมีประโยชน์มากที่สุด

กอดใบหน้า มีกระดานผู้นำ Open LLM ซึ่งติดตาม ประเมิน และจัดอันดับ LLM เมื่อมีการเปิดตัว พวกเขาใช้กรอบงานที่เป็นเอกลักษณ์ซึ่งใช้ในการทดสอบแบบจำลองภาษาเชิงสร้างสรรค์ในงานประเมินผลที่แตกต่างกัน

ล่าสุด LLaMA (Large Language Model Meta AI) อยู่ในอันดับต้นๆ ของกระดานผู้นำ และเพิ่งถูกโค่นล้มโดย LLM ใหม่ที่ได้รับการฝึกล่วงหน้าอย่าง Falcon 40B

ภาพโดย กระดานผู้นำ HuggingFace Open LLM

ฟอลคอน แอลแอลเอ็ม ถูกก่อตั้งและสร้างโดย. สถาบันนวัตกรรมเทคโนโลยี (TII) ซึ่งเป็นบริษัทที่เป็นส่วนหนึ่งของสภาวิจัยเทคโนโลยีขั้นสูงของรัฐบาลอาบูดาบี รัฐบาลดูแลการวิจัยเทคโนโลยีทั่วทั้งสหรัฐอาหรับเอมิเรตส์ ซึ่งทีมนักวิทยาศาสตร์ นักวิจัย และวิศวกรมุ่งเน้นไปที่การนำเสนอเทคโนโลยีที่เปลี่ยนแปลงและการค้นพบทางวิทยาศาสตร์

ฟอลคอน-40บี เป็น LLM พื้นฐานที่มีพารามิเตอร์ 40B ฝึกอบรมเกี่ยวกับโทเค็นหนึ่งล้านล้านโทเค็น Falcon 40B เป็นรุ่นถอดรหัสอัตโนมัติเท่านั้น โมเดลเฉพาะตัวถอดรหัสแบบ autoregressive หมายความว่าโมเดลนั้นได้รับการฝึกฝนให้ทำนายโทเค็นถัดไปตามลำดับที่กำหนดให้กับโทเค็นก่อนหน้า โมเดล GPT เป็นตัวอย่างที่ดีของสิ่งนี้

สถาปัตยกรรมของ Falcon ได้รับการแสดงให้เห็นว่ามีประสิทธิภาพเหนือกว่า GPT-3 อย่างมากด้วยงบประมาณการประมวลผลการฝึกอบรมเพียง 75% เท่านั้น และต้องการเพียง ? ของการคำนวณในเวลาอนุมาน

คุณภาพข้อมูลตามขนาดเป็นจุดสนใจที่สำคัญของทีมที่ Technology Innovation Institute เนื่องจากเรารู้ว่า LLM มีความอ่อนไหวสูงต่อคุณภาพของข้อมูลการฝึกอบรม ทีมงานสร้างไปป์ไลน์ข้อมูลซึ่งปรับขนาดเป็นคอร์ CPU นับหมื่นเพื่อการประมวลผลที่รวดเร็ว และสามารถดึงเนื้อหาคุณภาพสูงจากเว็บโดยใช้การกรองและการขจัดข้อมูลซ้ำซ้อนที่ครอบคลุม

พวกเขายังมีอีกรุ่นที่เล็กกว่า: ฟอลคอน-7บี ซึ่งมีพารามิเตอร์ 7B ฝึกฝนกับโทเค็น 1,500B เช่นเดียวกับก Falcon-40B-คำสั่งและ Falcon-7B-คำสั่ง มีโมเดลให้เลือกหากคุณกำลังมองหาโมเดลแชทที่พร้อมใช้งาน

Falcon 40B ทำอะไรได้บ้าง?

เช่นเดียวกับ LLM อื่นๆ Falcon 40B สามารถ:

Falcon 40B ได้รับการฝึกฝนอย่างไร

ด้วยการฝึกอบรมบนโทเค็น 1 ล้านล้านโทเค็น ต้องใช้ GPU 384 ตัวบน AWS เป็นเวลากว่าสองเดือน ฝึกฝนด้วยโทเค็น 1,000B กลั่นเว็บซึ่งเป็นชุดข้อมูลเว็บภาษาอังกฤษขนาดใหญ่ที่สร้างโดย TII

ข้อมูลก่อนการฝึกอบรมประกอบด้วยการรวบรวมข้อมูลสาธารณะจากเว็บที่ใช้ CommonCrawl. ทีมงานได้ผ่านขั้นตอนการกรองอย่างละเอียดเพื่อลบข้อความที่เครื่องสร้างขึ้น และเนื้อหาสำหรับผู้ใหญ่ตลอดจนการขจัดข้อมูลซ้ำซ้อนเพื่อสร้างชุดข้อมูลการฝึกอบรมล่วงหน้าที่มีโทเค็นเกือบห้าล้านล้านโทเค็นได้ถูกรวบรวมไว้

ชุดข้อมูล RefinedWeb ที่สร้างขึ้นบน CommonCrawl ได้แสดงโมเดลเพื่อให้ได้ประสิทธิภาพที่ดีกว่าโมเดลที่ได้รับการฝึกบนชุดข้อมูลที่ได้รับการดูแลจัดการ RefinedWeb ยังเป็นมิตรกับหลายรูปแบบอีกด้วย

เมื่อพร้อมแล้ว Falcon จะได้รับการตรวจสอบเทียบกับการวัดประสิทธิภาพแบบโอเพ่นซอร์ส เช่น EAI Harness, HELM และ BigBench

พวกเขามี Falcon LLM แบบโอเพ่นซอร์ส สู่สาธารณะ ทำให้ Falcon 40B และ 7B เข้าถึงได้มากขึ้นสำหรับนักวิจัยและนักพัฒนา เนื่องจากเป็นไปตามการเปิดตัว Apache License เวอร์ชัน 2.0

LLM ซึ่งครั้งหนึ่งเคยมีไว้เพื่อการวิจัยและเชิงพาณิชย์เท่านั้น บัดนี้ได้กลายเป็นโอเพ่นซอร์สเพื่อตอบสนองความต้องการทั่วโลกในการเข้าถึง AI อย่างครอบคลุม ขณะนี้ไม่มีค่าลิขสิทธิ์สำหรับข้อจำกัดการใช้งานเชิงพาณิชย์ เนื่องจากสหรัฐอาหรับเอมิเรตส์มุ่งมั่นที่จะเปลี่ยนแปลงความท้าทายและขอบเขตภายใน AI และวิธีที่ AI จะมีบทบาทสำคัญในอนาคต

Apache 2.0 มุ่งมั่นที่จะปลูกฝังระบบนิเวศของการทำงานร่วมกัน นวัตกรรม และการแบ่งปันความรู้ในโลกของ AI รับประกันความปลอดภัยและซอฟต์แวร์โอเพ่นซอร์สที่ปลอดภัย

หากคุณต้องการลองใช้ Falcon-40B เวอร์ชันที่เรียบง่ายกว่า ซึ่งเหมาะกับคำสั่งทั่วไปในรูปแบบของแชทบอตมากกว่า คุณจะต้องใช้ Falcon-7B

มาเริ่มกันเลย…

หากคุณยังไม่ได้ติดตั้งแพ็คเกจต่อไปนี้:

เมื่อคุณติดตั้งแพ็คเกจเหล่านี้แล้ว คุณสามารถไปยังการรันโค้ดที่ให้ไว้ได้ คำแนะนำเหยี่ยว 7-B:

Falcon ถือเป็นโมเดลโอเพ่นซอร์สที่ดีที่สุดและครองตำแหน่ง LLaMAs และผู้คนต่างประหลาดใจกับสถาปัตยกรรมที่ได้รับการปรับให้เหมาะสมที่สุด เป็นโอเพ่นซอร์สพร้อมลิขสิทธิ์เฉพาะตัว และมีจำหน่ายในสองขนาด: พารามิเตอร์ 40B และ 7B

คุณได้ลอง? หากคุณมีโปรดแจ้งให้เราทราบในความคิดเห็นว่าคุณคิดอย่างไร

ณิชา อารยา เป็นนักวิทยาศาสตร์ข้อมูล นักเขียนด้านเทคนิคอิสระ และผู้จัดการชุมชนที่ KDnuggets เธอสนใจเป็นพิเศษในการให้คำแนะนำด้านอาชีพของ Data Science หรือแบบฝึกหัดและความรู้ตามทฤษฎีเกี่ยวกับ Data Science นอกจากนี้ เธอยังต้องการสำรวจวิธีการต่างๆ ของปัญญาประดิษฐ์ที่สามารถเป็นประโยชน์ต่อการมีอายุยืนยาวของมนุษย์ ใฝ่เรียนรู้ ต้องการเพิ่มพูนความรู้ด้านเทคโนโลยีและทักษะการเขียน ในขณะที่ช่วยแนะนำผู้อื่น

เพิ่มเติมในหัวข้อนี้

The Ultimate Home Office Part 1

TVL ของ Zircuit ทะลุ 2 พันล้านดอลลาร์ก่อนการเปิดตัว Mainnet ในช่วงฤดูร้อน

ราคา XRP จับตาการทะลุทะลวงเนื่องจากนักวิเคราะห์คาดการณ์ว่าจะมีการเพิ่มขึ้น 150%

Bitcoin Runes คิดเป็น 57.7% ของธุรกรรมในช่วง Halving Day

ผู้ใช้ผู้ช่วย AI สามารถพัฒนา 'ความผูกพันทางอารมณ์' กับพวกเขา Google เตือน - ถอดรหัส

นักลงทุนสร้างกลุ่มเพื่อดำเนินการทางกฎหมายกับผู้ร่วมก่อตั้ง ZKasino

CompTIA สนับสนุนความพยายามของกระทรวงกลาโหมเพื่อเสริมสร้างความรู้และทักษะทางไซเบอร์

เหตุใดแท็กซี่ไร้คนขับของ Waymo จึงขับผิดข้างถนน SF

Shiba Inu หรือ Dogecoin: Meme Coin ไหนที่จะซื้อเพื่อรับกำไร 10 เท่า?

การอัปเดต IQT Vancouver/Pacific Rim: Chris Hickman หัวหน้าเจ้าหน้าที่รักษาความปลอดภัยของคีย์แฟคเตอร์เป็นวิทยากรปี 2024 – Inside Quantum Technology