Зображення редактора

Ми спостерігаємо, як щотижня з’являються великі мовні моделі (LLM) із дедалі більшою кількістю чат-ботів для використання. Однак може бути важко зрозуміти, який із них найкращий, прогрес у кожному та який із них найбільш корисний.

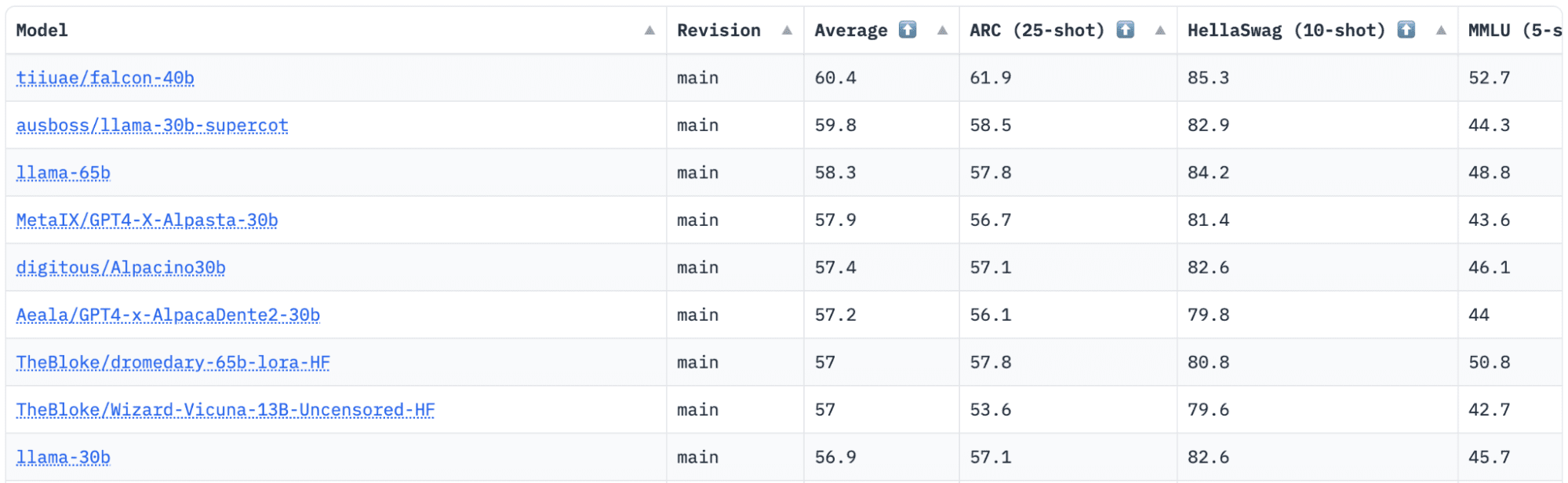

HuggingFace має Open LLM Leaderboard, який відстежує, оцінює та ранжує LLM під час їх випуску. Вони використовують унікальну структуру, яка використовується для тестування генеративних мовних моделей у різних завданнях оцінювання.

Нещодавно LLaMA (Large Language Model Meta AI) була на вершині таблиці лідерів і нещодавно була потіснена новим попередньо навченим LLM – Falcon 40B.

Зображення на Таблиця лідерів HuggingFace Open LLM

Falcon LLM був заснований і побудований Інститут технологічних інновацій (TII), компанію, яка входить до Науково-дослідної ради передових технологій уряду Абу-Дабі. Уряд контролює технологічні дослідження в усіх Об’єднаних Арабських Еміратах, де команда вчених, дослідників та інженерів зосереджена на розробці трансформаційних технологій і відкриттів у науці.

Сокіл-40Б є основоположним LLM з 40B параметрами, навчання на одному трильйоні токенів. Falcon 40B — це модель декодера з авторегресією. Модель лише авторегресійного декодера означає, що модель навчена передбачати наступний маркер у послідовності з урахуванням попередніх маркерів. Модель GPT є хорошим прикладом цього.

Було показано, що архітектура Falcon значно перевершує GPT-3 лише за 75% бюджету навчальних обчислень, а також вимагає лише ? обчислення під час висновку.

Якість даних у масштабі була важливою метою команди Інституту технологічних інновацій, оскільки ми знаємо, що магістратури дуже чутливі до якості навчальних даних. Команда створила конвеєр даних, який масштабувався до десятків тисяч ядер ЦП для швидкої обробки, і зміг отримати високоякісний вміст з Інтернету за допомогою розширеної фільтрації та дедуплікації.

Вони також мають іншу меншу версію: Сокіл-7Б який має 7B параметрів, навчених на 1,500B токенах. Як і а Falcon-40B-Instruct та Falcon-7B-Instruct доступні моделі, якщо ви шукаєте готову до використання модель чату.

Що може Falcon 40B?

Подібно до інших LLM, Falcon 40B може:

- Створюйте творчий контент

- Вирішувати складні задачі

- Операції з обслуговування клієнтів

- Віртуальні помічники

- Мовний переклад

- Аналіз настроїв.

- Скоротіть і автоматизуйте «повторювану» роботу.

- Допоможіть компаніям ОАЕ стати ефективнішими

Як проходила підготовка Falcon 40B?

Оскільки він навчався на 1 трильйоні токенів, йому знадобилося 384 графічних процесора на AWS протягом двох місяців. Навчався на 1,000 млрд токенів RefinedWeb, масивний англійський веб-набір даних, створений TII.

Дані попереднього навчання складалися з колекції загальнодоступних даних з Інтернету за допомогою CommonCrawl. Команда пройшла ретельний етап фільтрації, щоб видалити створений машиною текст, і було зібрано вміст для дорослих, а також будь-яку дедуплікацію, щоб створити переднавчальний набір даних із майже п’яти трильйонів токенів.

Створений на основі CommonCrawl набір даних RefinedWeb продемонстрував, що моделі досягають кращої продуктивності, ніж моделі, навчені на спеціально підібраних наборах даних. RefinedWeb також є мультимодальним.

Після того, як Falcon був готовий, його перевірили на тести відкритого коду, такі як EAI Harness, HELM і BigBench.

У них є Falcon LLM з відкритим кодом для громадськості, що робить Falcon 40B і 7B більш доступними для дослідників і розробників, оскільки вони базуються на випуску ліцензії Apache версії 2.0.

LLM, який раніше був лише для досліджень і комерційного використання, тепер став відкритим кодом, щоб задовольнити глобальний попит на інклюзивний доступ до ШІ. Тепер він вільний від ліцензійних платежів за обмеження комерційного використання, оскільки ОАЕ прагнуть змінити виклики та межі ШІ та те, як він відіграє важливу роль у майбутньому.

Прагнучи розвивати екосистему співпраці, інновацій та обміну знаннями у світі ШІ, Apache 2.0 забезпечує безпеку та безпечне програмне забезпечення з відкритим кодом.

Якщо ви хочете випробувати простішу версію Falcon-40B, яка краще підходить для загальних інструкцій у стилі чат-бота, вам потрібно використовувати Falcon-7B.

Тож почнемо…

Якщо ви ще цього не зробили, інсталюйте такі пакети:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Після того, як ви встановили ці пакунки, ви можете перейти до запуску передбаченого коду Falcon 7-B Instruct:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch model = "tiiuae/falcon-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline( "text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.bfloat16, trust_remote_code=True, device_map="auto",

)

sequences = pipeline( "Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:", max_length=200, do_sample=True, top_k=10, num_return_sequences=1, eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences: print(f"Result: {seq['generated_text']}")

Falcon, визнаний найкращою доступною моделлю з відкритим вихідним кодом, отримав корону LLaMAs, і люди вражені його сильно оптимізованою архітектурою, відкритим вихідним кодом з унікальною ліцензією та доступним у двох розмірах: параметри 40B і 7B.

Ви пробували? Якщо у вас є, повідомте нам у коментарях, що ви думаєте.

Ніша Арья є дослідником даних, позаштатним технічним автором і менеджером спільноти в KDnuggets. Вона особливо зацікавлена в наданні кар’єрних порад щодо Data Science або навчальних посібників і теоретичних знань щодо Data Science. Вона також хоче вивчити різні способи, якими штучний інтелект приносить/може підвищити тривалість людського життя. Завзято навчається, прагне розширити свої технічні знання та навички письма, водночас допомагаючи керувати іншими.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- EVM Фінанси. Уніфікований інтерфейс для децентралізованих фінансів. Доступ тут.

- Quantum Media Group. ІЧ/ПР посилений. Доступ тут.

- PlatoAiStream. Web3 Data Intelligence. Розширення знань. Доступ тут.

- джерело: https://www.kdnuggets.com/2023/06/falcon-llm-new-king-llms.html?utm_source=rss&utm_medium=rss&utm_campaign=falcon-llm-the-new-king-of-open-source-llms

Falcon LLM: новий король програм магістра права з відкритим кодом – KDnuggets

Перевидано Платоном

Зображення редактора

Ми спостерігаємо, як щотижня з’являються великі мовні моделі (LLM) із дедалі більшою кількістю чат-ботів для використання. Однак може бути важко зрозуміти, який із них найкращий, прогрес у кожному та який із них найбільш корисний.

HuggingFace має Open LLM Leaderboard, який відстежує, оцінює та ранжує LLM під час їх випуску. Вони використовують унікальну структуру, яка використовується для тестування генеративних мовних моделей у різних завданнях оцінювання.

Нещодавно LLaMA (Large Language Model Meta AI) була на вершині таблиці лідерів і нещодавно була потіснена новим попередньо навченим LLM – Falcon 40B.

Зображення на Таблиця лідерів HuggingFace Open LLM

Falcon LLM був заснований і побудований Інститут технологічних інновацій (TII), компанію, яка входить до Науково-дослідної ради передових технологій уряду Абу-Дабі. Уряд контролює технологічні дослідження в усіх Об’єднаних Арабських Еміратах, де команда вчених, дослідників та інженерів зосереджена на розробці трансформаційних технологій і відкриттів у науці.

Сокіл-40Б є основоположним LLM з 40B параметрами, навчання на одному трильйоні токенів. Falcon 40B — це модель декодера з авторегресією. Модель лише авторегресійного декодера означає, що модель навчена передбачати наступний маркер у послідовності з урахуванням попередніх маркерів. Модель GPT є хорошим прикладом цього.

Було показано, що архітектура Falcon значно перевершує GPT-3 лише за 75% бюджету навчальних обчислень, а також вимагає лише ? обчислення під час висновку.

Якість даних у масштабі була важливою метою команди Інституту технологічних інновацій, оскільки ми знаємо, що магістратури дуже чутливі до якості навчальних даних. Команда створила конвеєр даних, який масштабувався до десятків тисяч ядер ЦП для швидкої обробки, і зміг отримати високоякісний вміст з Інтернету за допомогою розширеної фільтрації та дедуплікації.

Вони також мають іншу меншу версію: Сокіл-7Б який має 7B параметрів, навчених на 1,500B токенах. Як і а Falcon-40B-Instruct та Falcon-7B-Instruct доступні моделі, якщо ви шукаєте готову до використання модель чату.

Що може Falcon 40B?

Подібно до інших LLM, Falcon 40B може:

Як проходила підготовка Falcon 40B?

Оскільки він навчався на 1 трильйоні токенів, йому знадобилося 384 графічних процесора на AWS протягом двох місяців. Навчався на 1,000 млрд токенів RefinedWeb, масивний англійський веб-набір даних, створений TII.

Дані попереднього навчання складалися з колекції загальнодоступних даних з Інтернету за допомогою CommonCrawl. Команда пройшла ретельний етап фільтрації, щоб видалити створений машиною текст, і було зібрано вміст для дорослих, а також будь-яку дедуплікацію, щоб створити переднавчальний набір даних із майже п’яти трильйонів токенів.

Створений на основі CommonCrawl набір даних RefinedWeb продемонстрував, що моделі досягають кращої продуктивності, ніж моделі, навчені на спеціально підібраних наборах даних. RefinedWeb також є мультимодальним.

Після того, як Falcon був готовий, його перевірили на тести відкритого коду, такі як EAI Harness, HELM і BigBench.

У них є Falcon LLM з відкритим кодом для громадськості, що робить Falcon 40B і 7B більш доступними для дослідників і розробників, оскільки вони базуються на випуску ліцензії Apache версії 2.0.

LLM, який раніше був лише для досліджень і комерційного використання, тепер став відкритим кодом, щоб задовольнити глобальний попит на інклюзивний доступ до ШІ. Тепер він вільний від ліцензійних платежів за обмеження комерційного використання, оскільки ОАЕ прагнуть змінити виклики та межі ШІ та те, як він відіграє важливу роль у майбутньому.

Прагнучи розвивати екосистему співпраці, інновацій та обміну знаннями у світі ШІ, Apache 2.0 забезпечує безпеку та безпечне програмне забезпечення з відкритим кодом.

Якщо ви хочете випробувати простішу версію Falcon-40B, яка краще підходить для загальних інструкцій у стилі чат-бота, вам потрібно використовувати Falcon-7B.

Тож почнемо…

Якщо ви ще цього не зробили, інсталюйте такі пакети:

Після того, як ви встановили ці пакунки, ви можете перейти до запуску передбаченого коду Falcon 7-B Instruct:

Falcon, визнаний найкращою доступною моделлю з відкритим вихідним кодом, отримав корону LLaMAs, і люди вражені його сильно оптимізованою архітектурою, відкритим вихідним кодом з унікальною ліцензією та доступним у двох розмірах: параметри 40B і 7B.

Ви пробували? Якщо у вас є, повідомте нам у коментарях, що ви думаєте.

Ніша Арья є дослідником даних, позаштатним технічним автором і менеджером спільноти в KDnuggets. Вона особливо зацікавлена в наданні кар’єрних порад щодо Data Science або навчальних посібників і теоретичних знань щодо Data Science. Вона також хоче вивчити різні способи, якими штучний інтелект приносить/може підвищити тривалість людського життя. Завзято навчається, прагне розширити свої технічні знання та навички письма, водночас допомагаючи керувати іншими.

Більше на цю тему

‘Alien: Rogue Incursion’ Finally Announced From Veteran VR Studio, Set for Late 2024

Stripe знову виходить на ринок криптовалютних платежів зі стейблкойном USDC – Tech Startups

10 найбільших раундів фінансування тижня: Xaira та інші стартапи AI мають великий тиждень

Занепокоєння щодо дальності електромобіля: усе це справді у вашій голові – CleanTechnica

Redwood Materials має хороші новини про електромобілі – CleanTechnica

Сплеск зростання Stripe: від платіжного процесора до фінансового центру

15 найкращих програм Xero та інтеграцій Xero на Xero Marketplace 2024